qwen2-vl适配昇腾开源验证任务心得

qwen2-vl适配昇腾开源验证任务心得

根据发布任务中的任务计划书了解任务内容,主要目的是在昇腾npu上完成qwen2-vl模型的训练推理,确保其在昇腾上能够正常运行。

开发过程

在qwen2-vl的github网址中,提到可用llama-factory跑qwen2-vl模型,明确目的后开始熟悉框架,搭建llama-factory框架所需环境,Llama-factory的github网址:https://github.com/hiyouga/LLaMA-Factory,把Llama-factory项目从github上用git命令拉取下来。

NPU验证

(1)安装依赖包

NPU上需要CANN、torch_npu、pytorch

先安装CANN,参考:

https://www.hiascend.com/zh/developer/download/community/result?module=cann。

torch_npu的安装参考:https://github.com/Ascend/pytorch/blob/master/README.zh.md。

Llama_factory适配NPU还需要下载:pip install -e ".[torch-npu,metrics]"。

注:python环境为3.8的话,torch_npu、torch均下载2.1.0版本,transformer下载4.46.1版本,tokenizers下载0.20.3版本,否则会报错。

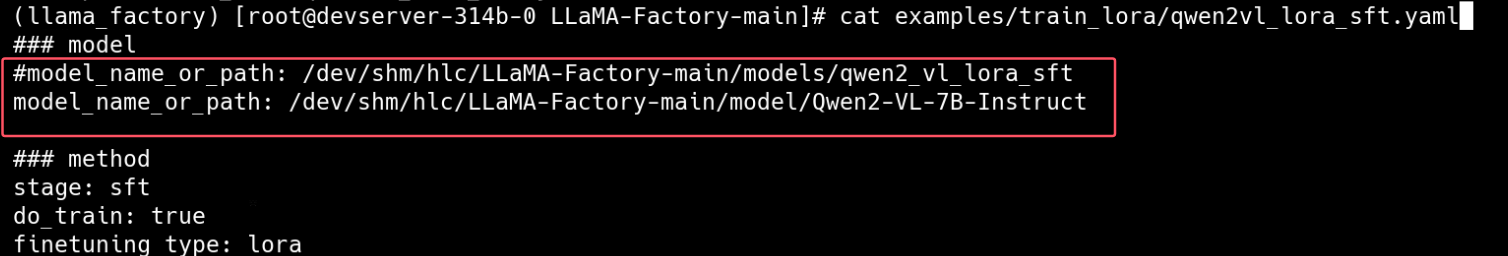

(2)训练、推理脚本:修改模型的权重文件路径

1、训练:examples/train_lora/qwen2vl_lora_sft.yaml

2、推理:example/inference/qwen2-vl.yaml

推理使用的模型文件路径是训练之后生成的新模型文件

![]()

1 验证截图

1.1验证思路

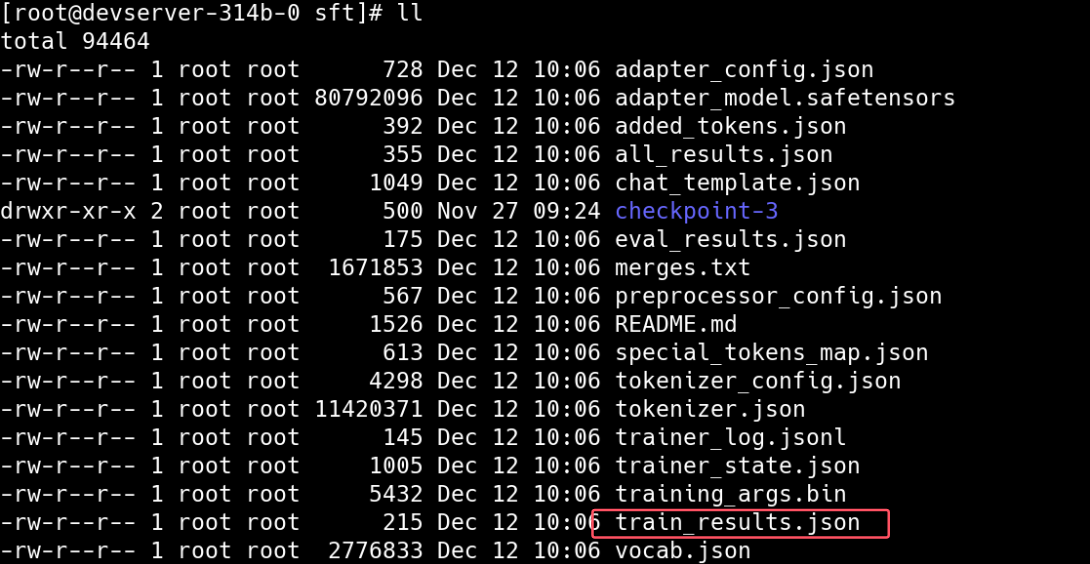

从github上拉取llama-factory仓库,使用modelscope下载模型放置model下,运行llama-factory中example/train_lora下的训练脚本,得到训练结果保存在saves下。

1.2 NPU训练验证结果

Qwen2-VL-7B-Instruct:

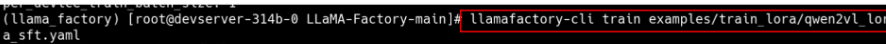

运行代码:

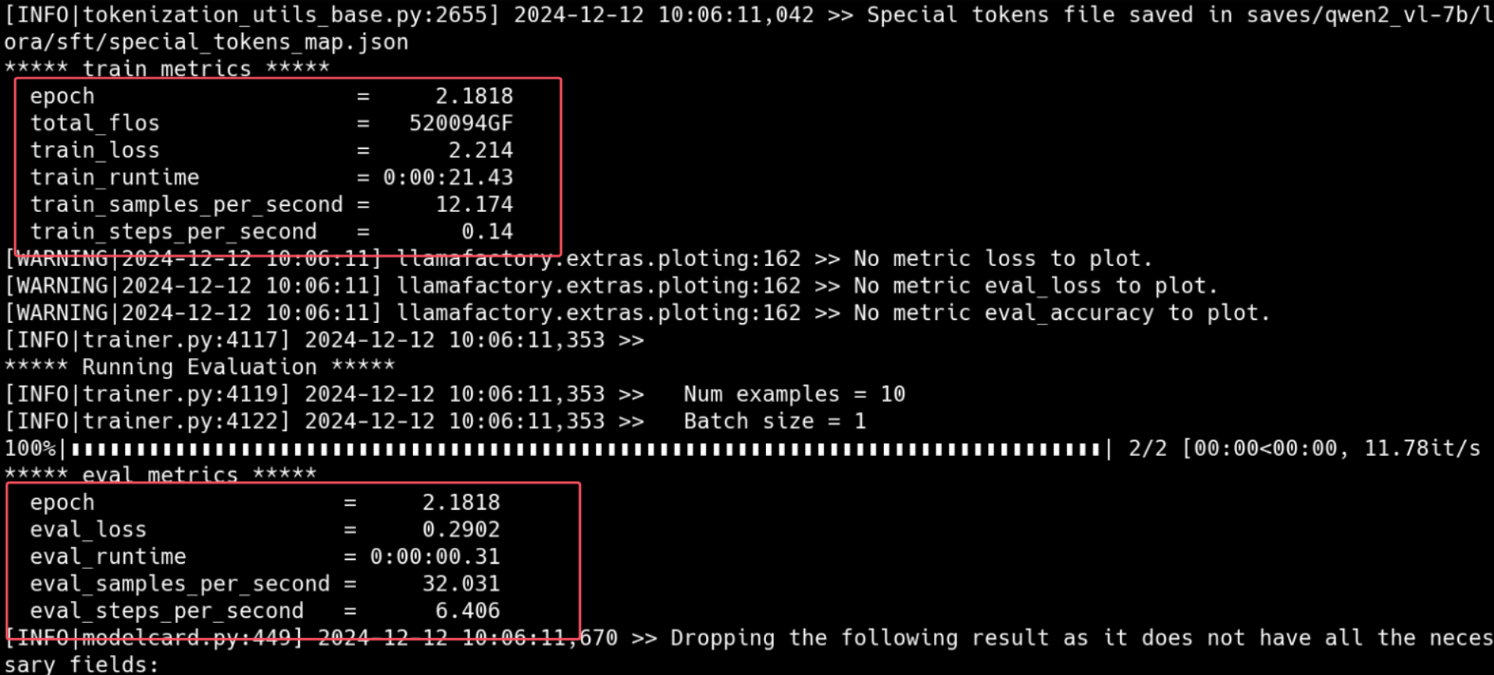

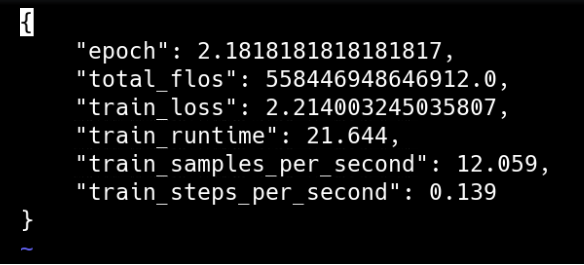

训练结果:

终端打印训练结果在终端并输出.json文件

生成train_result.json文件

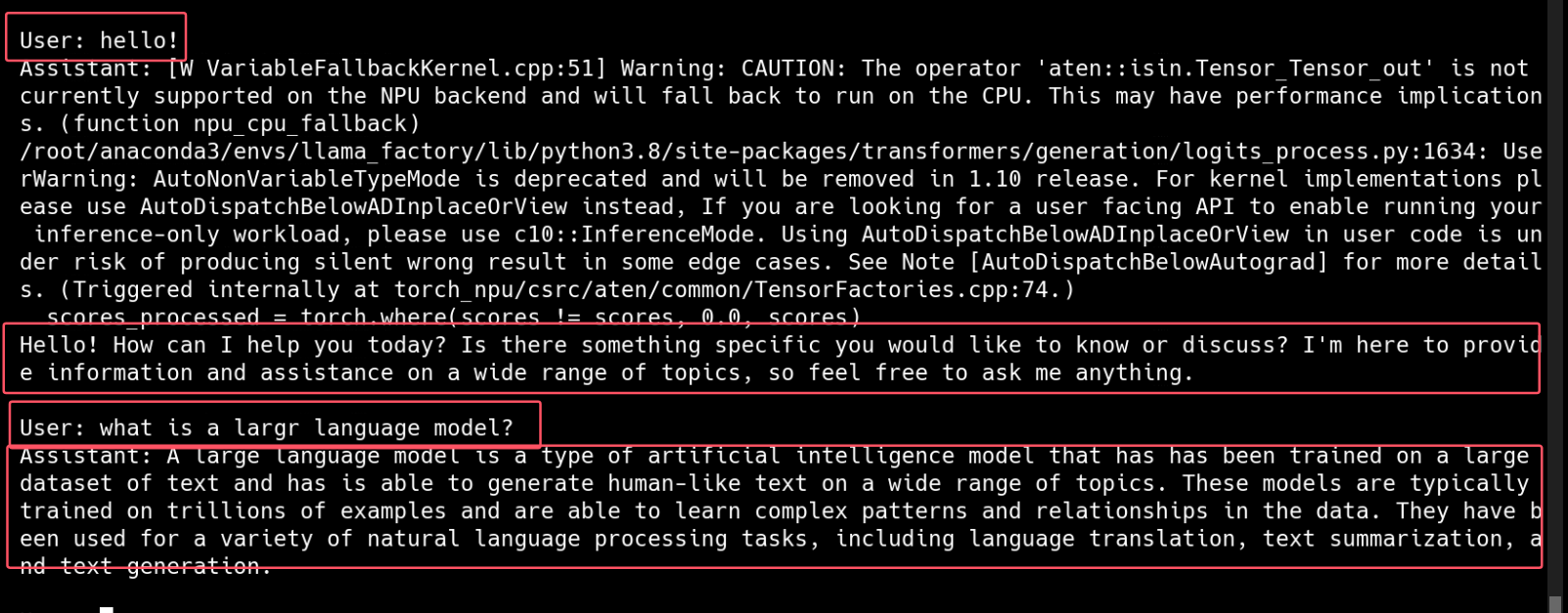

1.3NPU推理验证结果

运行代码:

运行结果:

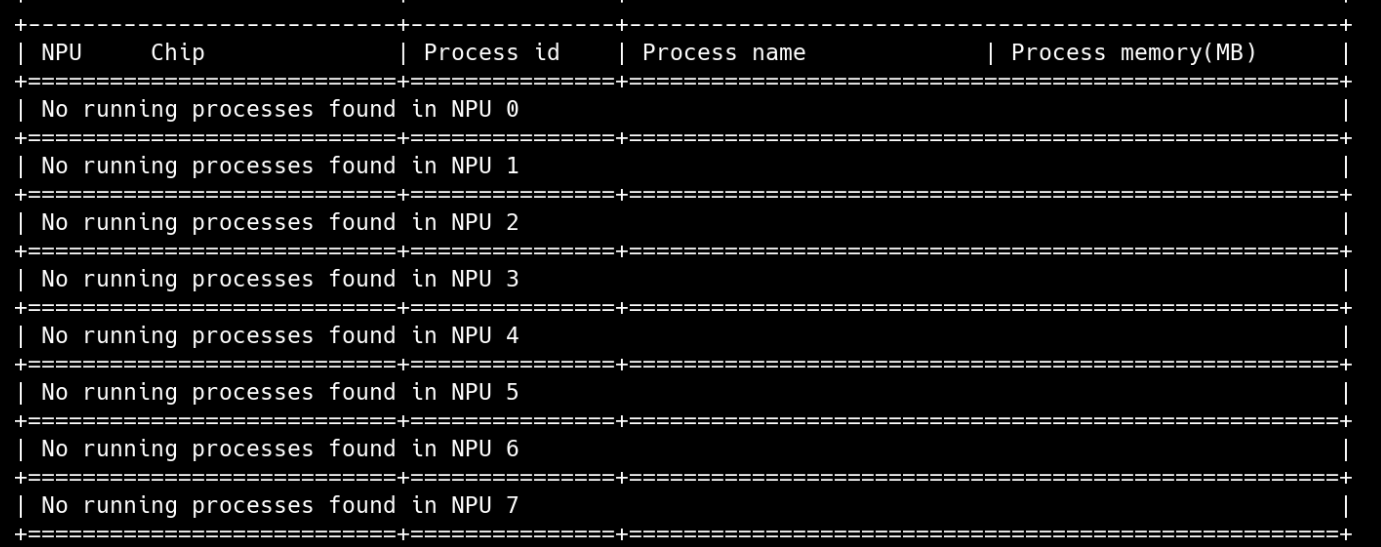

程序运行前:

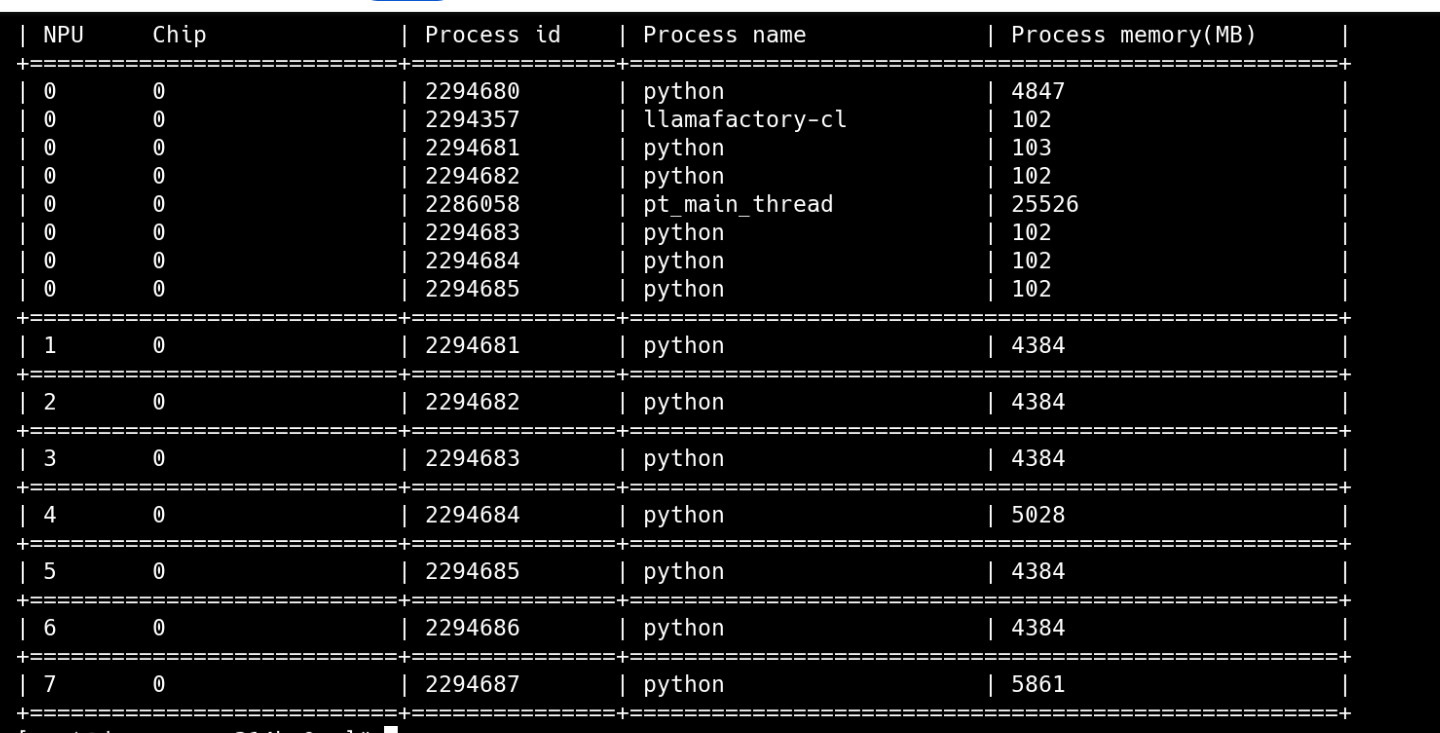

程序运行后:

- 点赞

- 收藏

- 关注作者

评论(0)