张小白带您跟随胡琦大大一起做蚂蚁牙黑Part Two:张小白本地JupyterLab的尝试

在 写了《张小白带您跟随胡琦大大一起做蚂蚁牙黑Part One:张小白的模仿》 https://bbs.huaweicloud.cn/blogs/246301 之后,张小白心想,这哪能体现出张小白的折腾能力?老是用ModelArts,总是担心花钱花钱的,累不累,本地能跑吗?于是就有了这一篇文字。

张小白的思路是这样的:

其实要完成蚂蚁牙黑这件事情,有几个环节:

(1)能够运行PyTorch 1.0的JupyterLab环境。

(2)准备好模型和素材——即OBS上的那个大zip文件。

(3)准备好与转换相关的相关代码——即那个折腾很久的代码仓。

(4)准备好蚂蚁牙黑的视频、待转换的图片,水印图片等。

这些东西都要从云端挪到本地,那我们就一个一个来呗。

(1)能够运行PyTorch 1.0的JupyterLab环境。

原来张小白已经在windows 10上安装了GPU的显卡驱动cuDNN https://bbs.huaweicloud.cn/blogs/212446

在此基础上先安装pytorch的GPU版本吧。(好在它不像MindSpore还没推出Windows的GPU版本。。。)

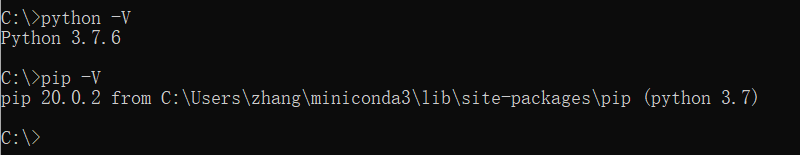

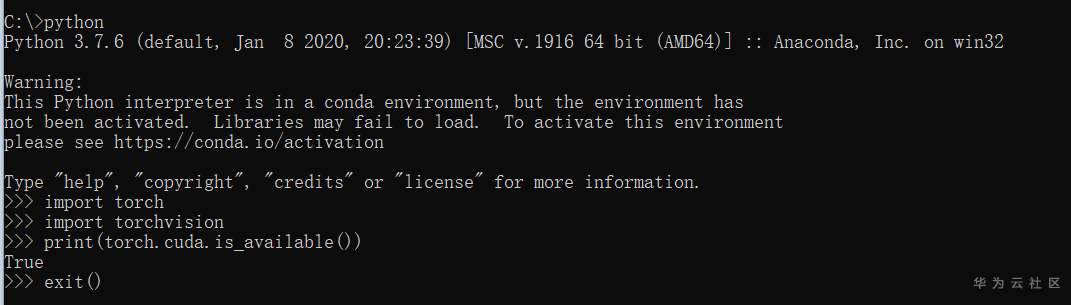

先看下本地的环境

python是3.7.6

nvcc -V查看CUDA版本为10.0

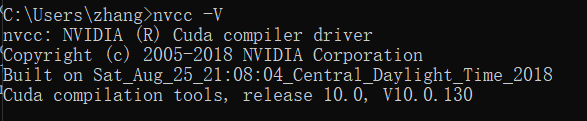

安装pytorch

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple torch==1.2.0 torchvision==0.4.0 -f https://download.pytorch.org/whl/torch_stable.html

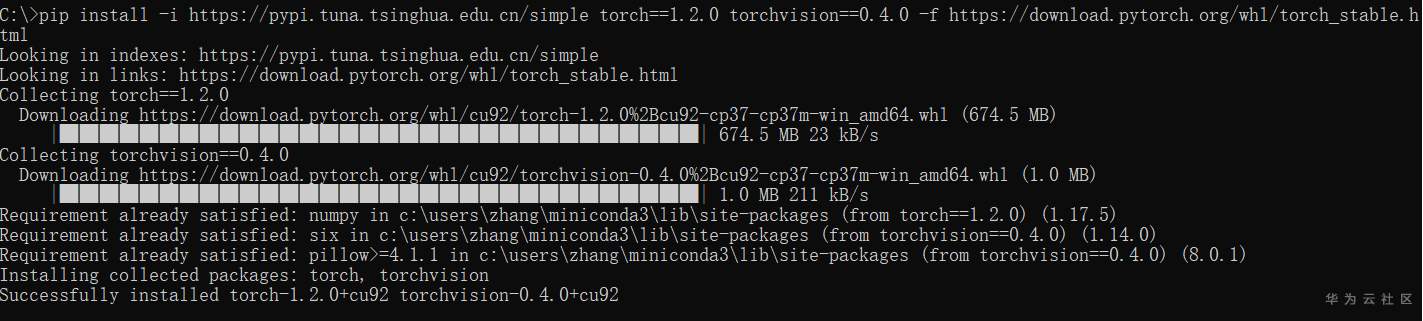

检查是否安装成功:

最后那个torch.cuda.is_available()返回True就说嘛Pytorch的GPU是没问题的。。。

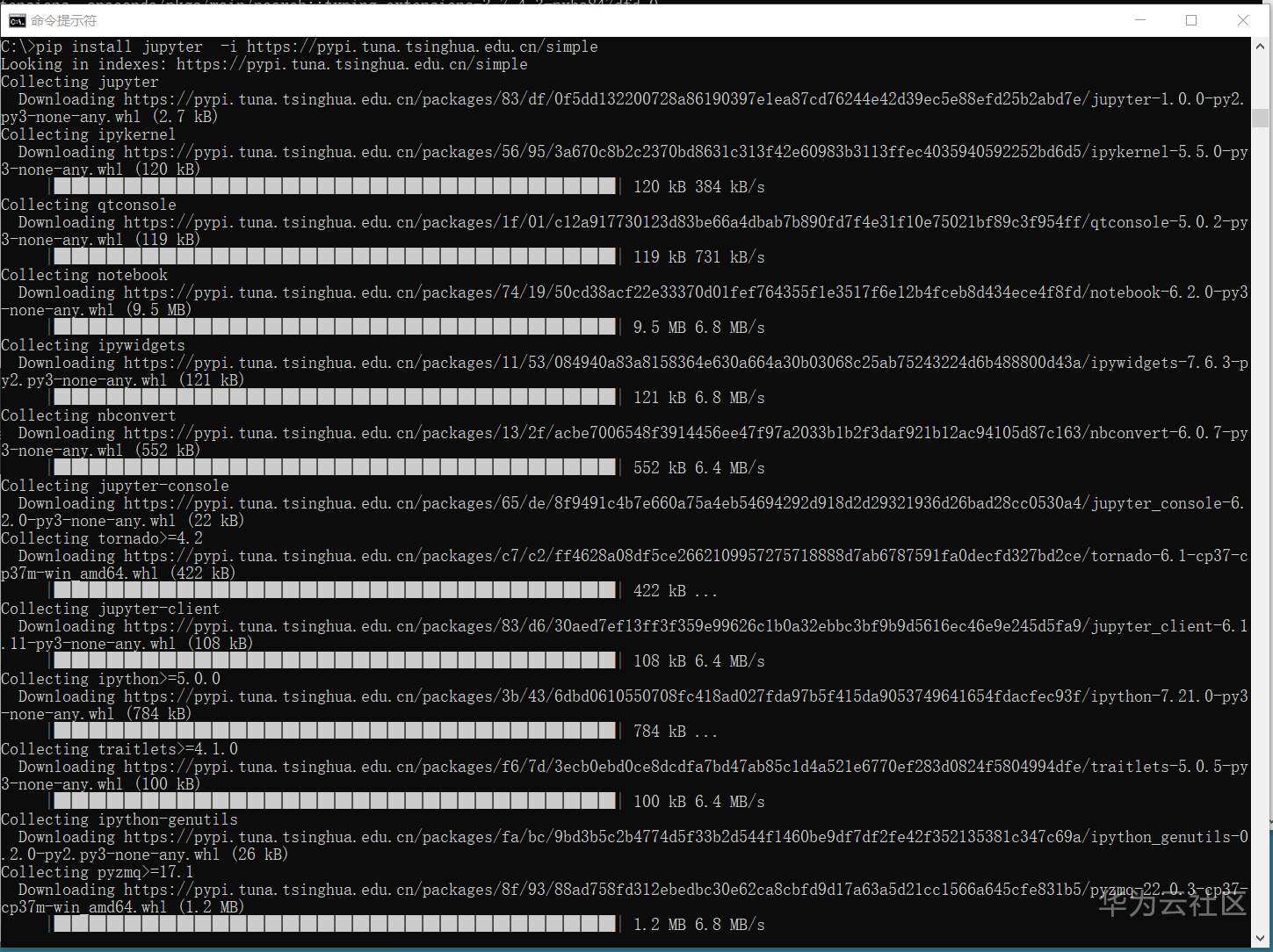

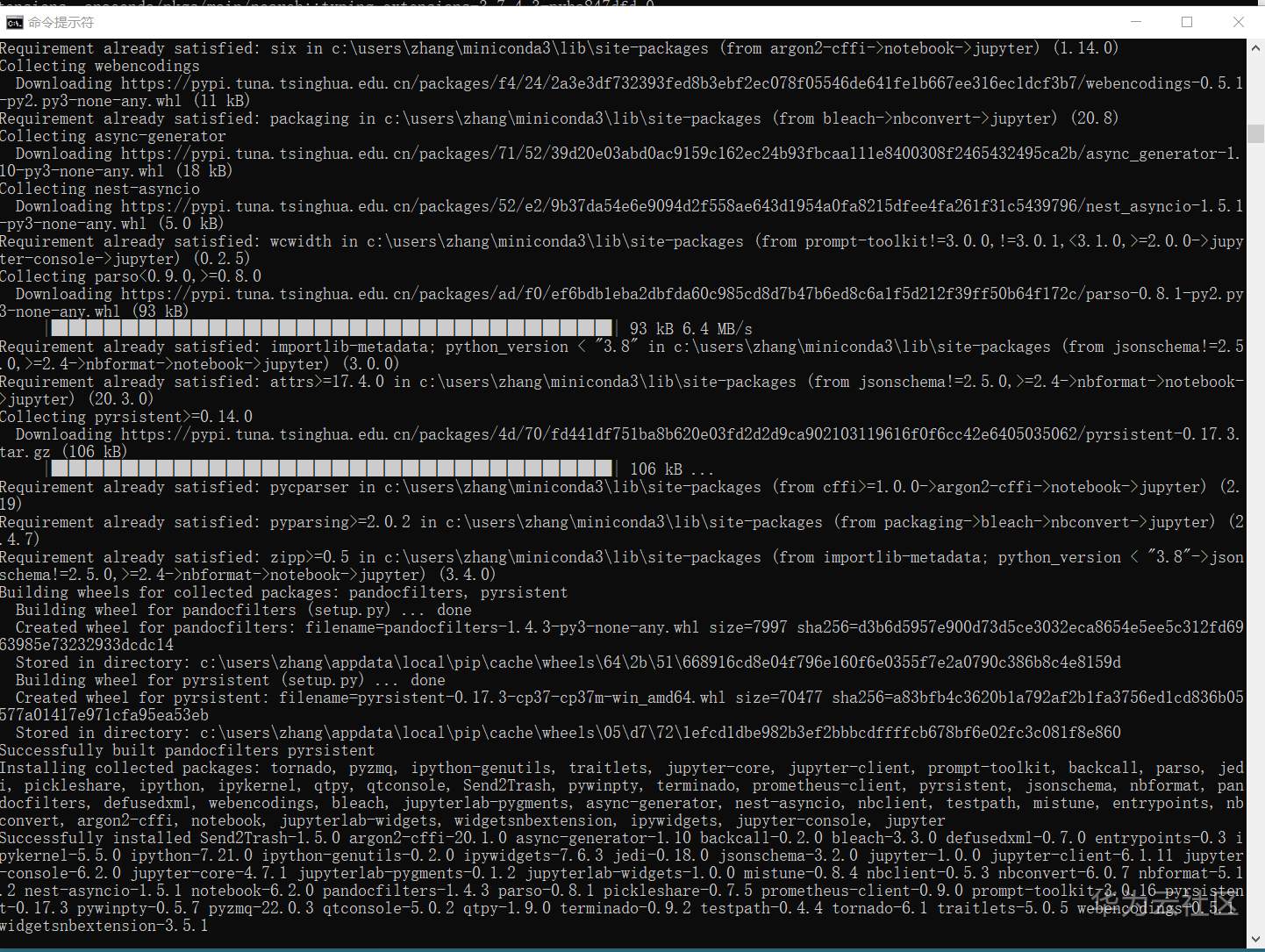

安装下jupyterLab

pip install jupyter -i https://pypi.tuna.tsinghua.edu.cn/simple

...

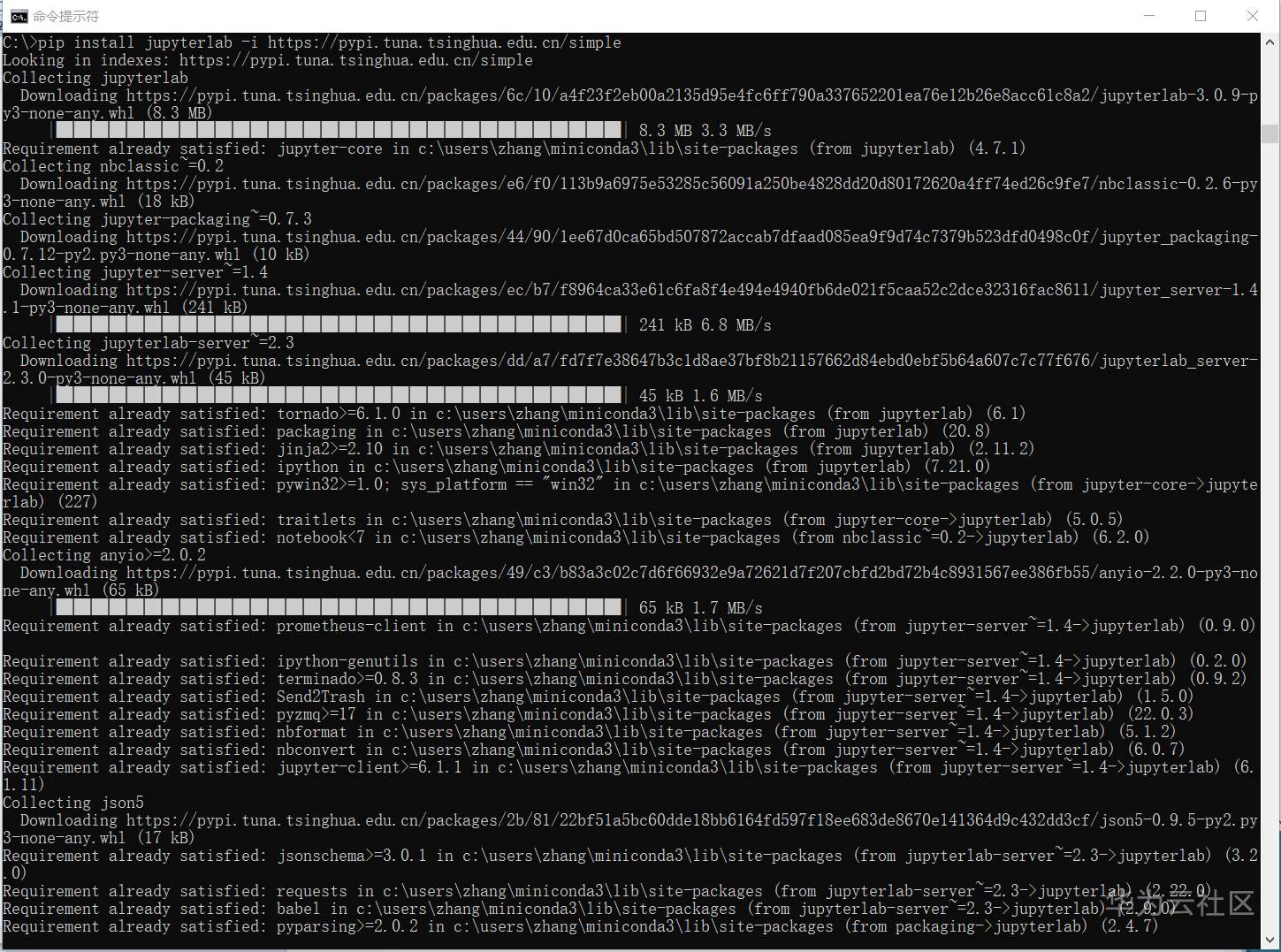

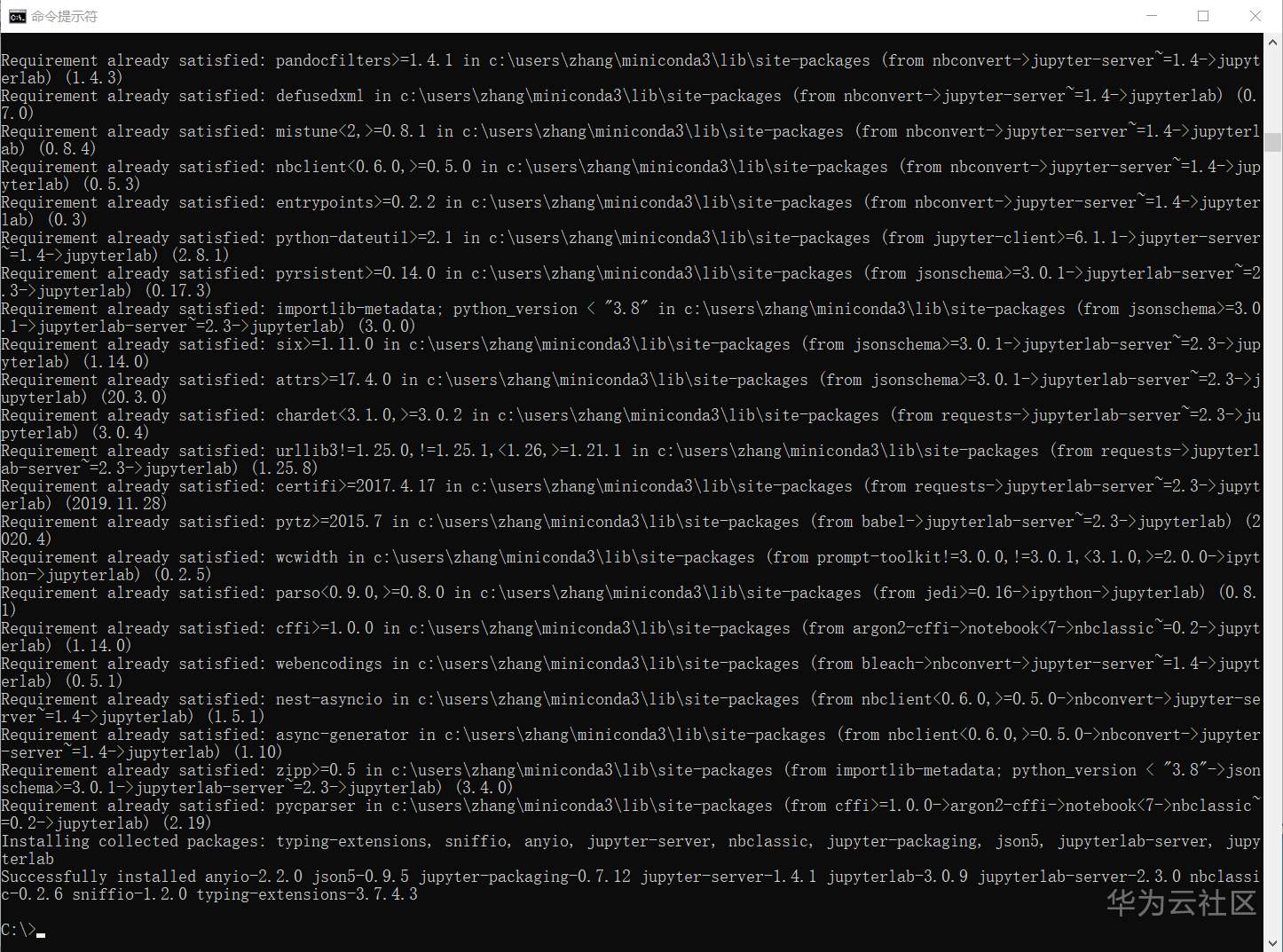

pip install jupyterlab -i https://pypi.tuna.tsinghua.edu.cn/simple

...

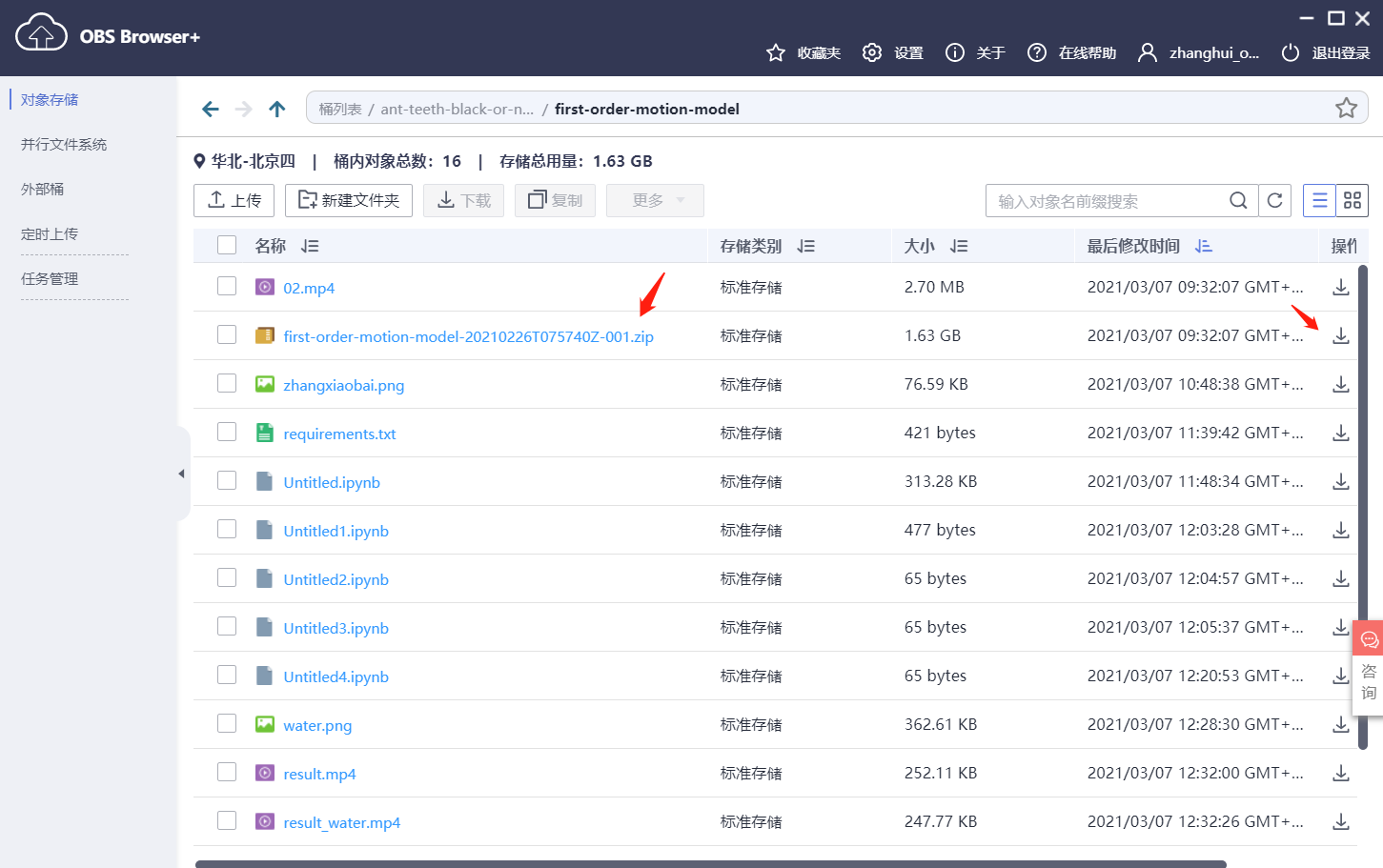

(2)准备好模型和素材——即OBS上的那个大zip文件。

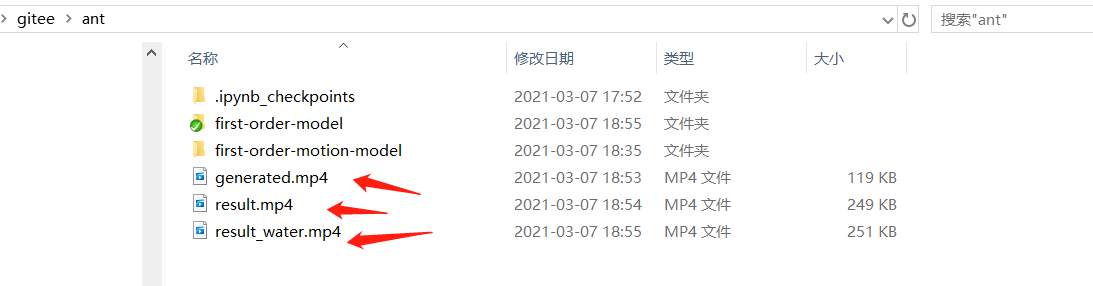

找个目录(这里是E:\gitee\ant目录)

使用obs-browser-plus将大的zip下载下来:

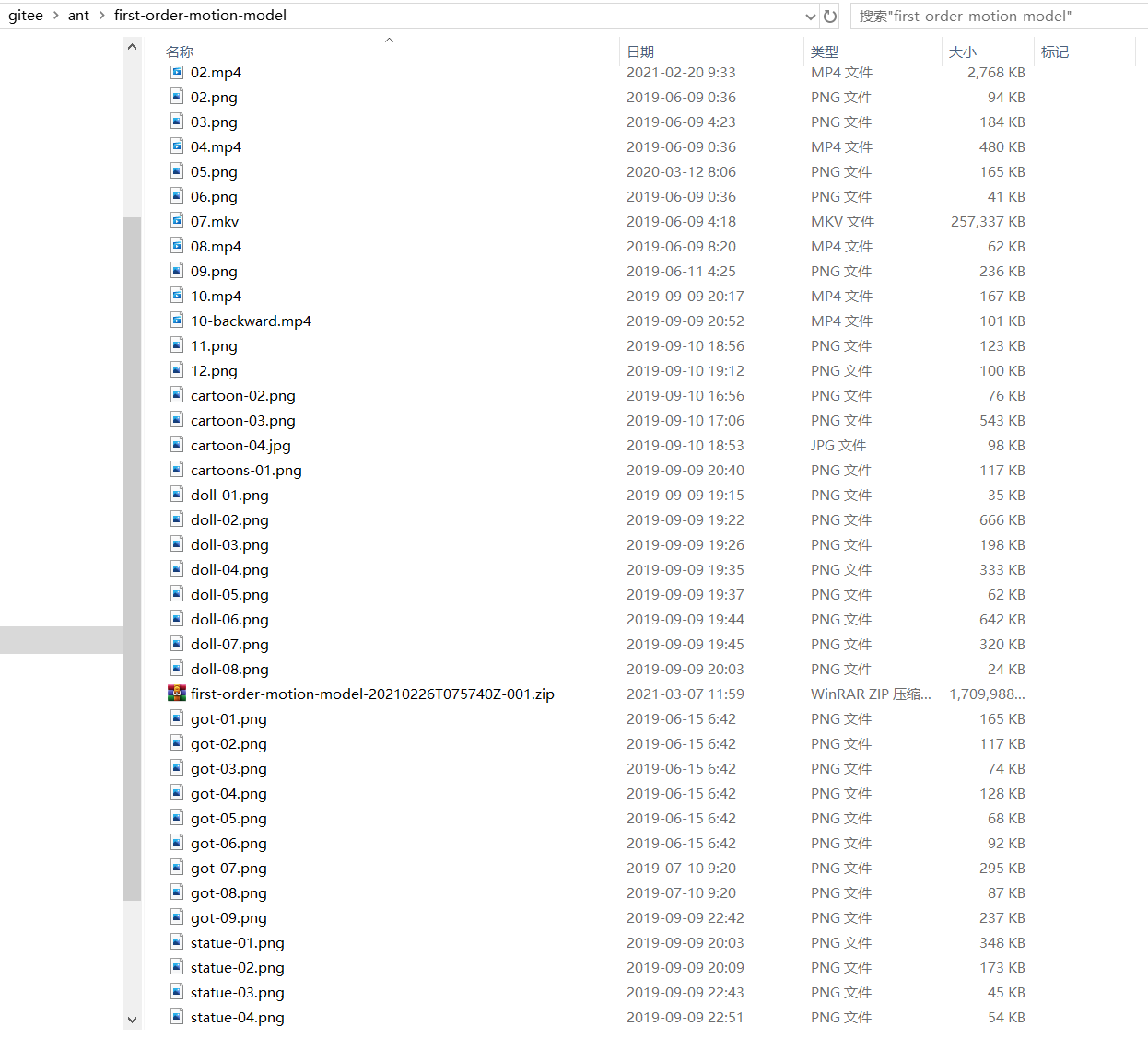

下载完毕后,解压文件到 E:\gitee\ant\first-order-motion-model 目录,跟ModelArts上的目录名保持一致。

(3)准备好与转换相关的相关代码——即那个折腾很久的代码仓。

git clone https://codehub.devcloud.cn-north-4.huaweicloud.cn/ai-pome-free00001/first-order-model.git

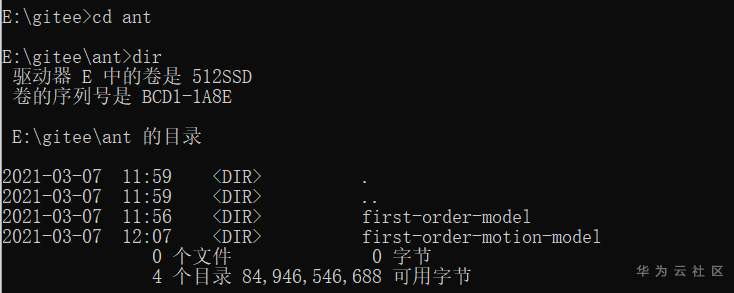

下载完毕后,形成以下两个目录

在这个目录下运行:

jupyter lab --no-browser

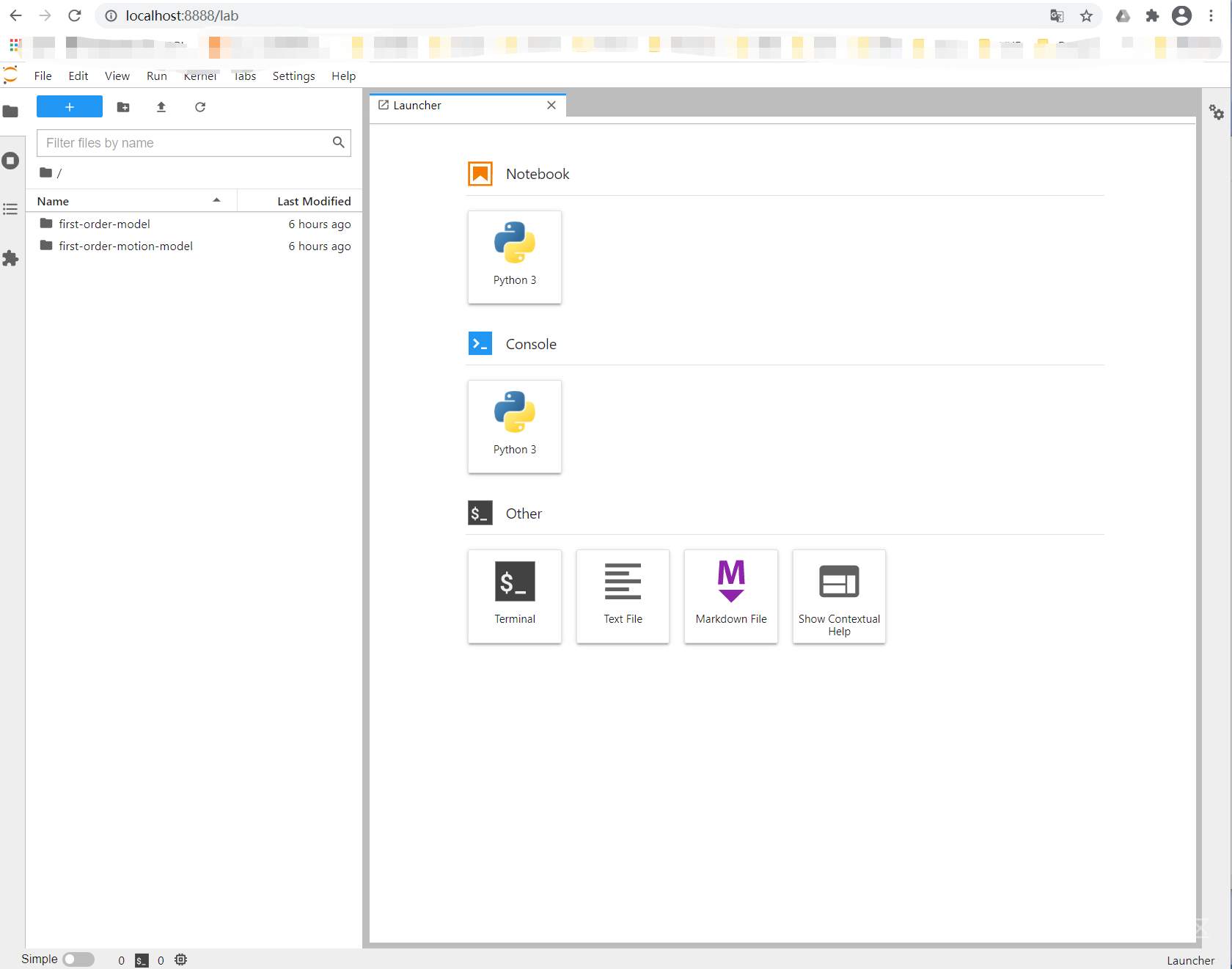

在浏览器打开上面提示的URL:

http://localhost:8888/lab?token=49ff125efb4c9361ab077d2aac4b899ee0ab08116ef29b7f

好像有点像ModelArts里面那个样子了。

(4)准备好蚂蚁牙黑的视频、待转换的图片,水印图片等。

这些文件在obs里面可以找到,分别下载即可。(其中有些都是自己传上去的。。。可以参见前一篇博客)

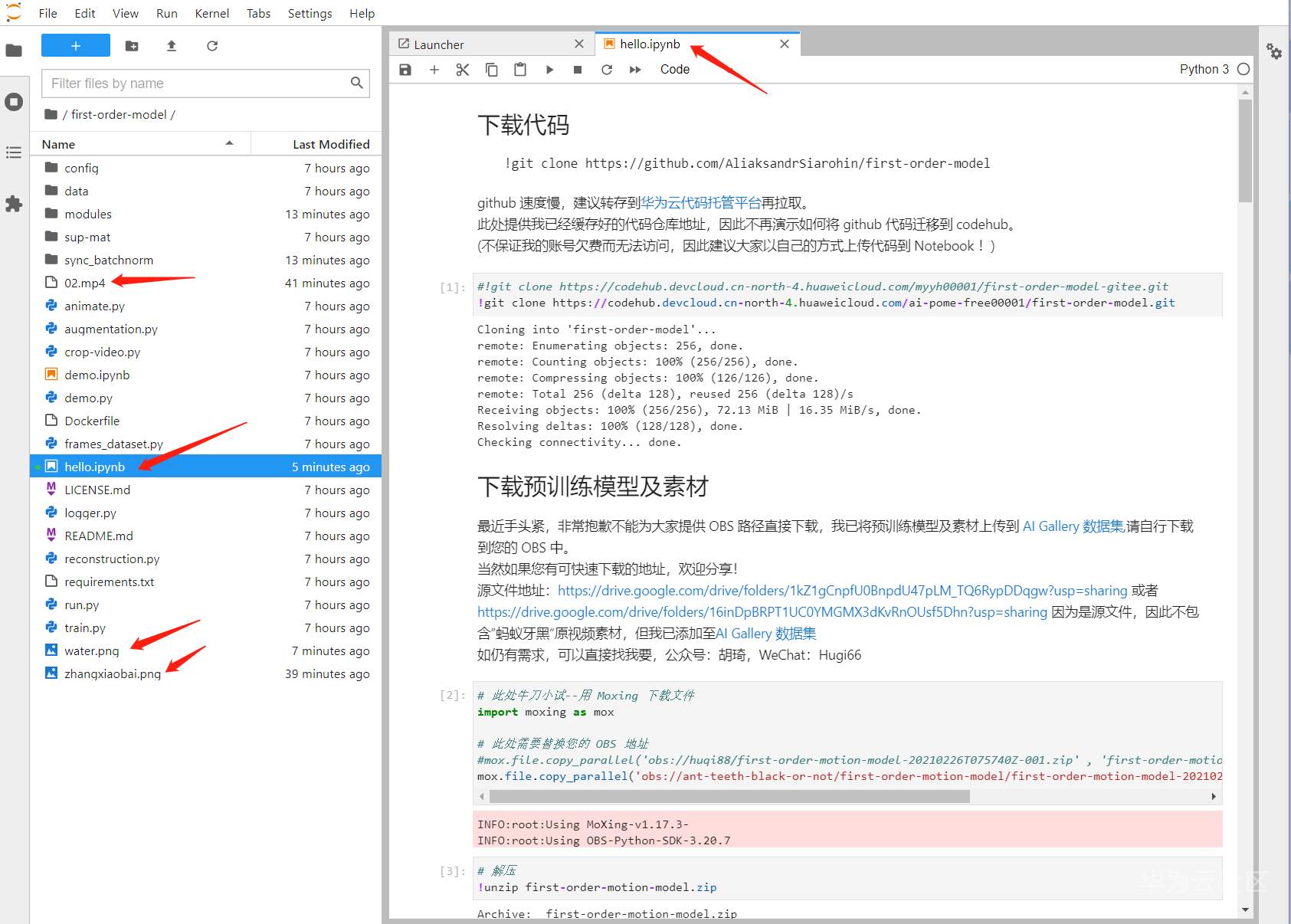

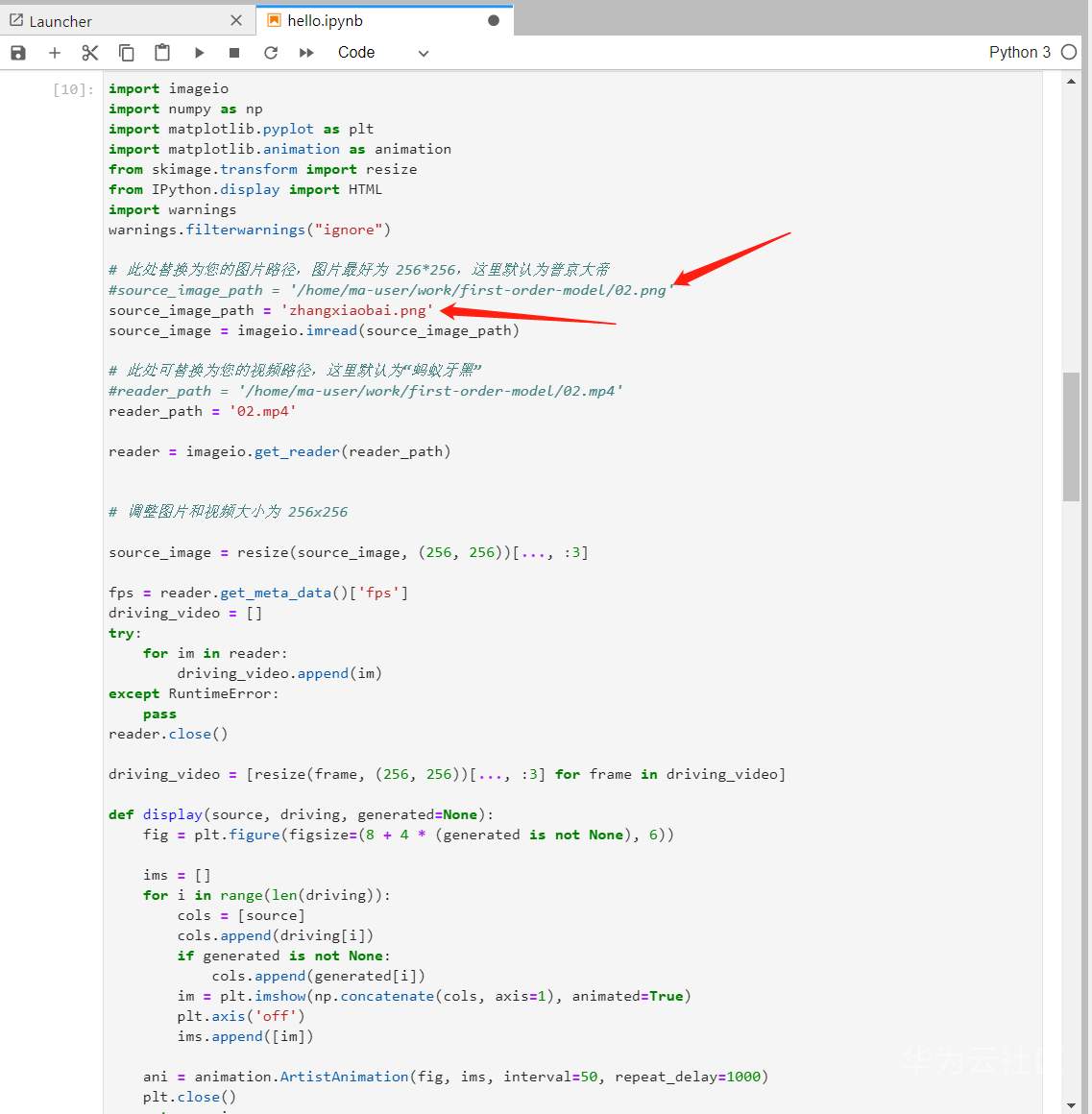

视频模板 02.mp4, 水印文件water.png和 人像的256X256图片 zhangxiaobai.png都拷贝到 first-order-model目录下。

好了,一切就绪了。那就开干吧。。

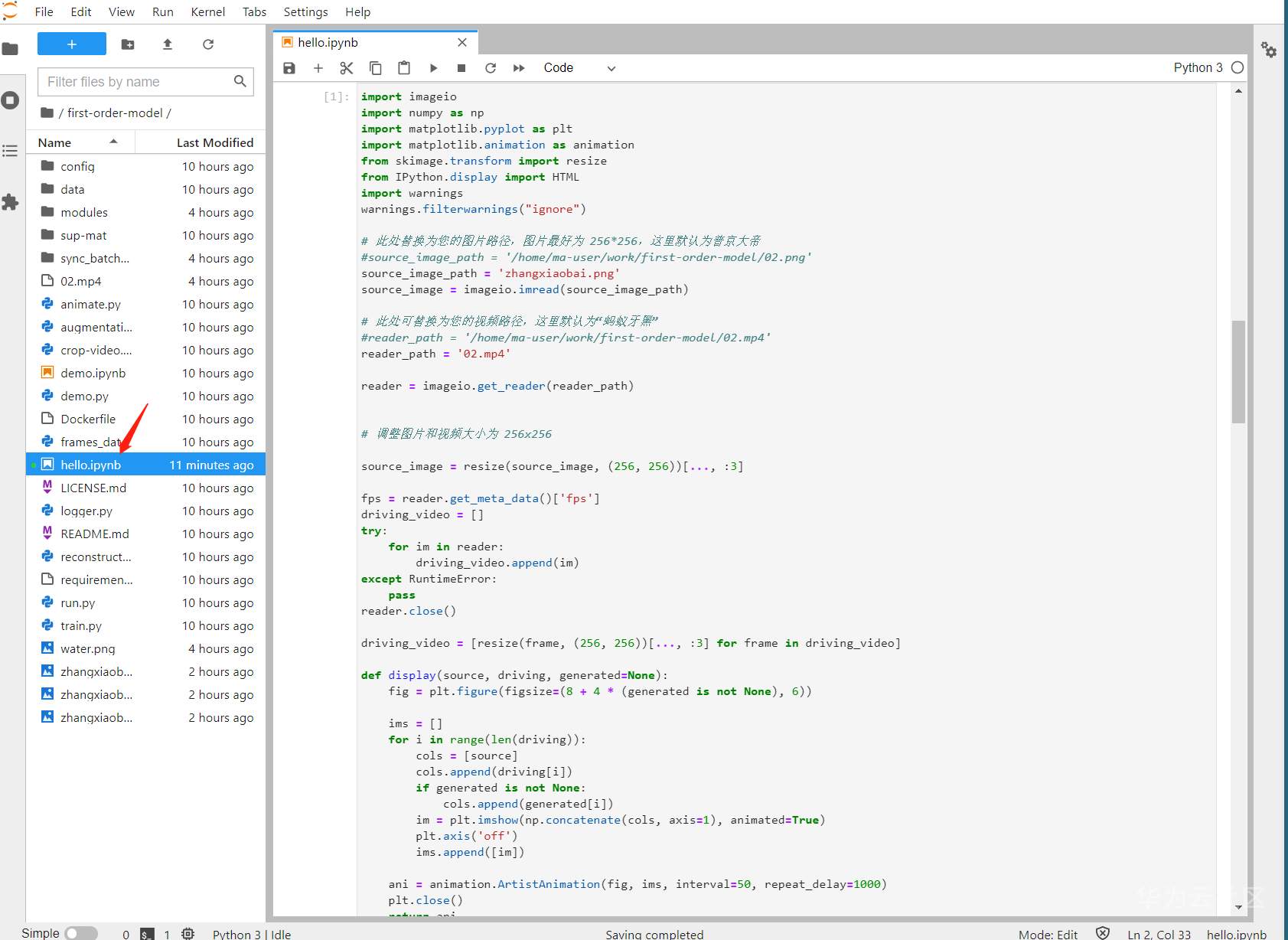

打开 hello.ipynb文件(就是从ModelArts生成后,从OBS下载下来的)

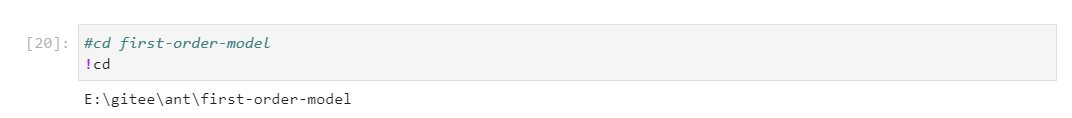

看一下当前目录:(运行下面的cell)

!cd

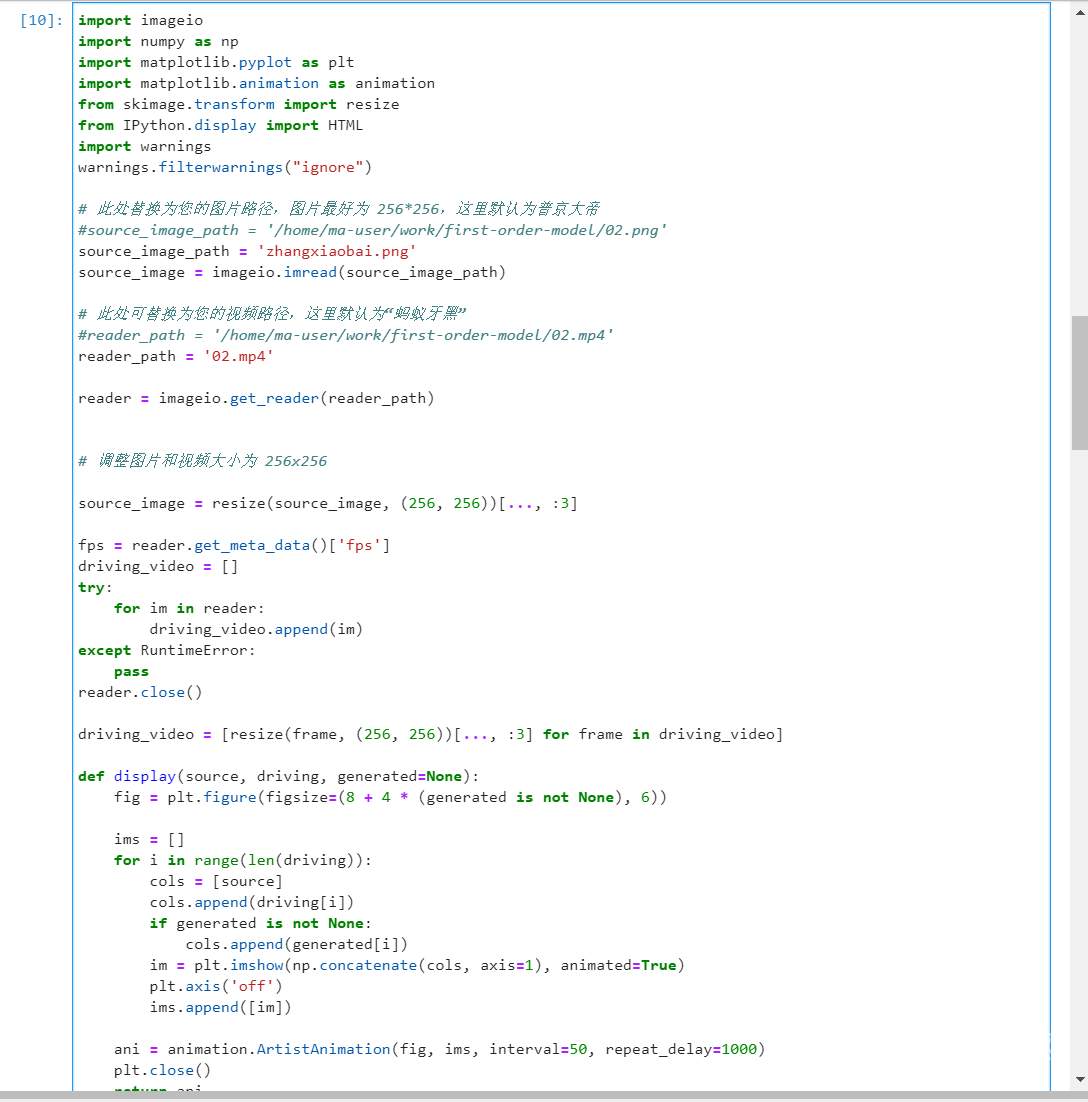

将脚本中的 绝对路径都改为 文件名或相对路径

运行上述cell会报一些包找不到。

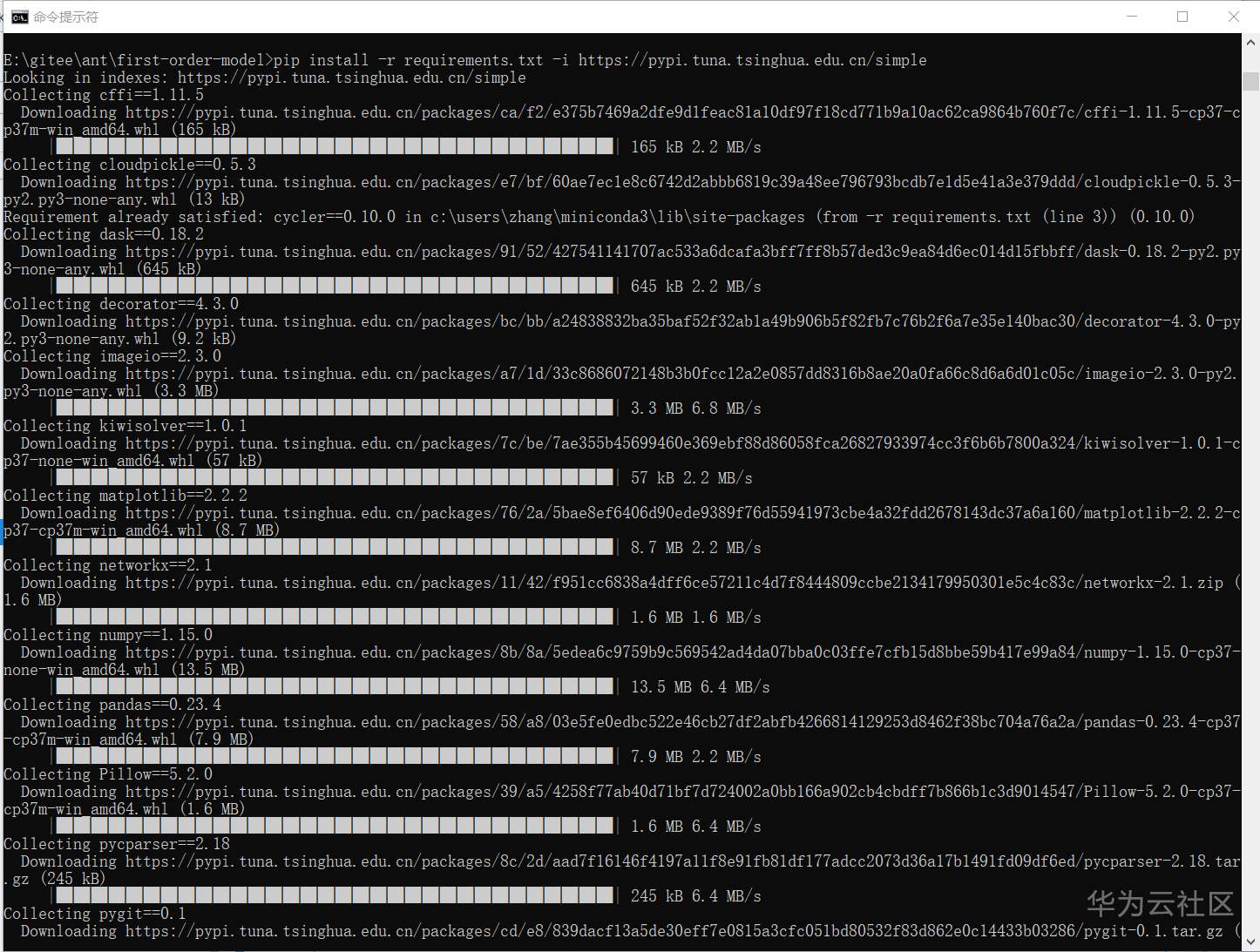

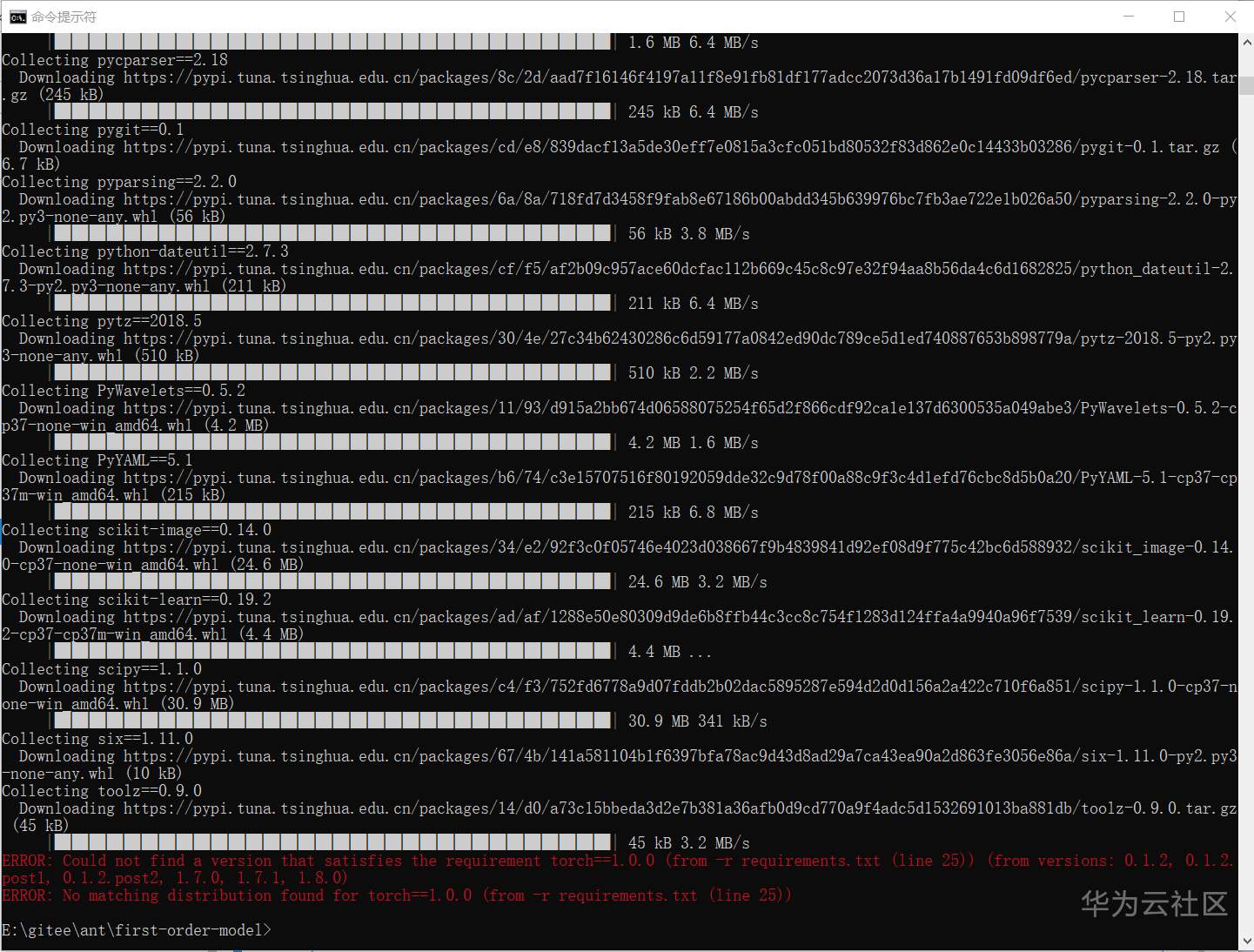

那我们就开始根据 E:\gitee\ant\first-order-model 目录下的readme,参照 requirements.txt,在cmd命令行窗口安装 需要的pip模块。

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

...

最后红色的是报torch和torchvision版本不对。因为目前机器已经安装的版本比requirements.txt中定义的要高,所以暂时不管。

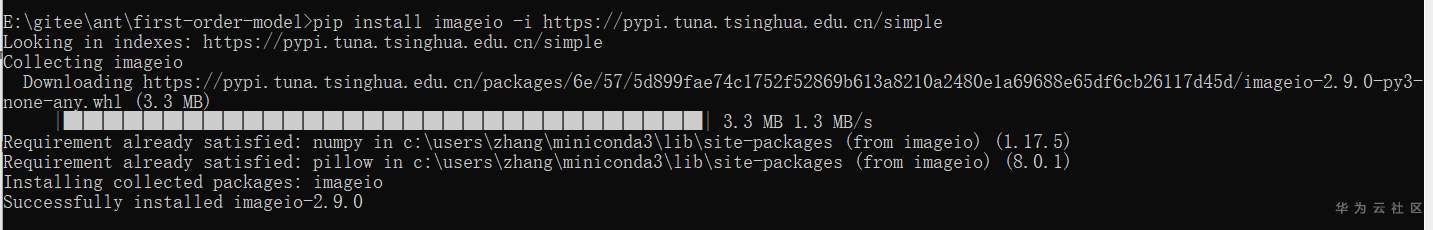

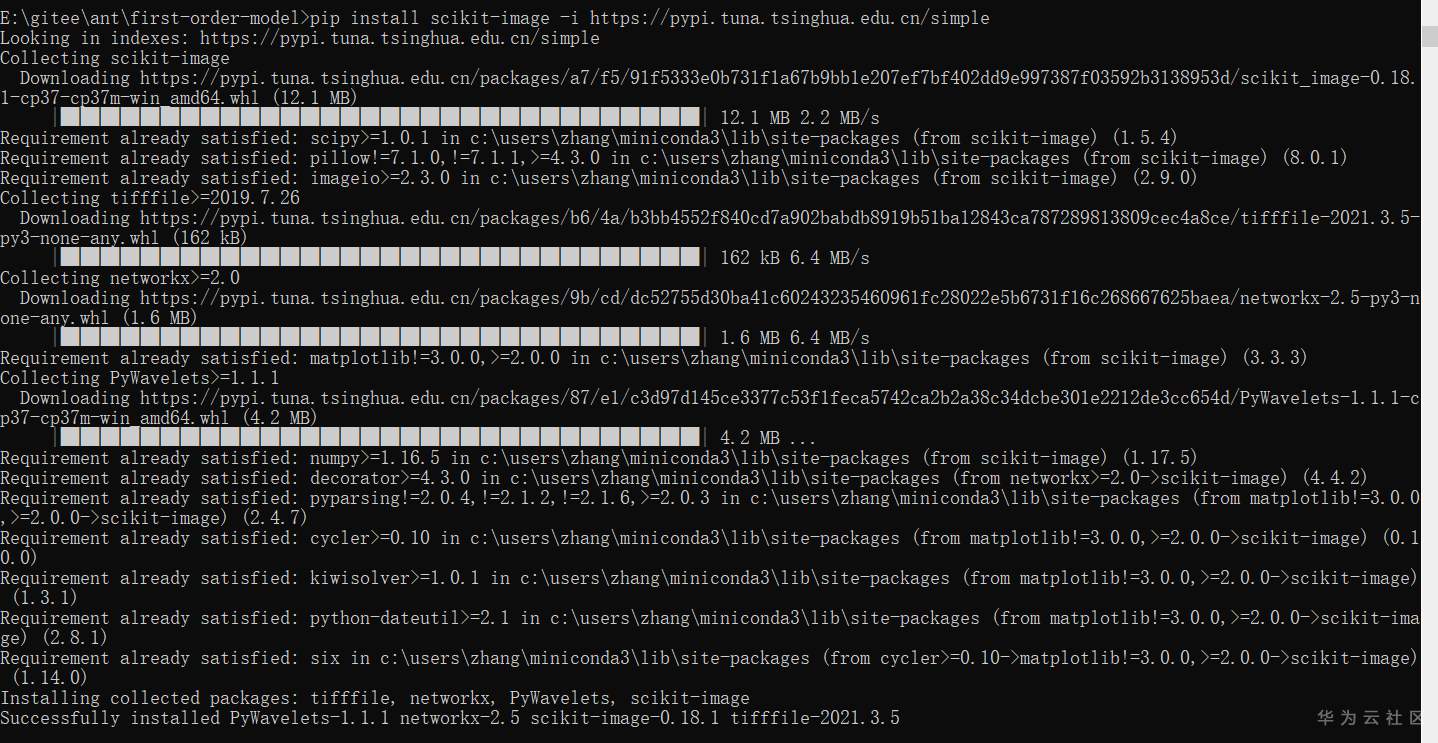

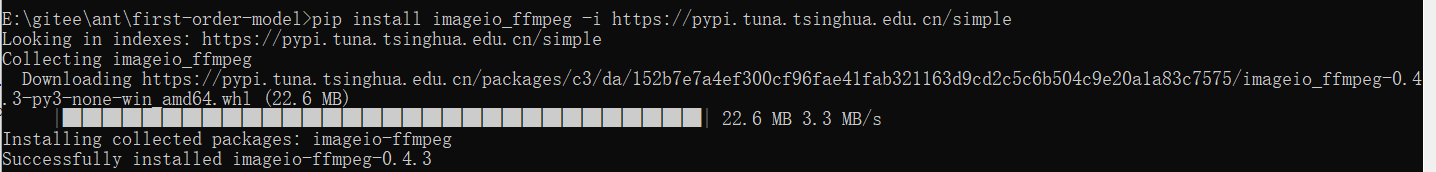

然后根据尝试第一个cell执行时的报错,分别安装以下包:

pip install imageio -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install scikit-image -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install imageio_ffmpeg -i https://pypi.tuna.tsinghua.edu.cn/simple

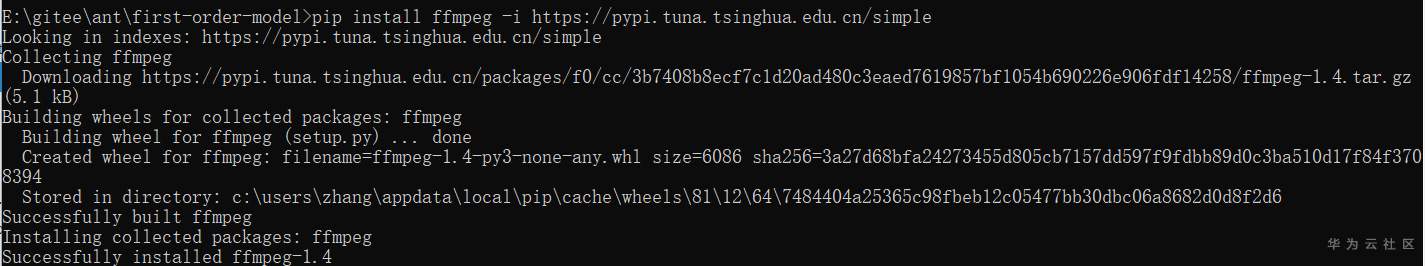

pip install ffmpeg -i https://pypi.tuna.tsinghua.edu.cn/simple

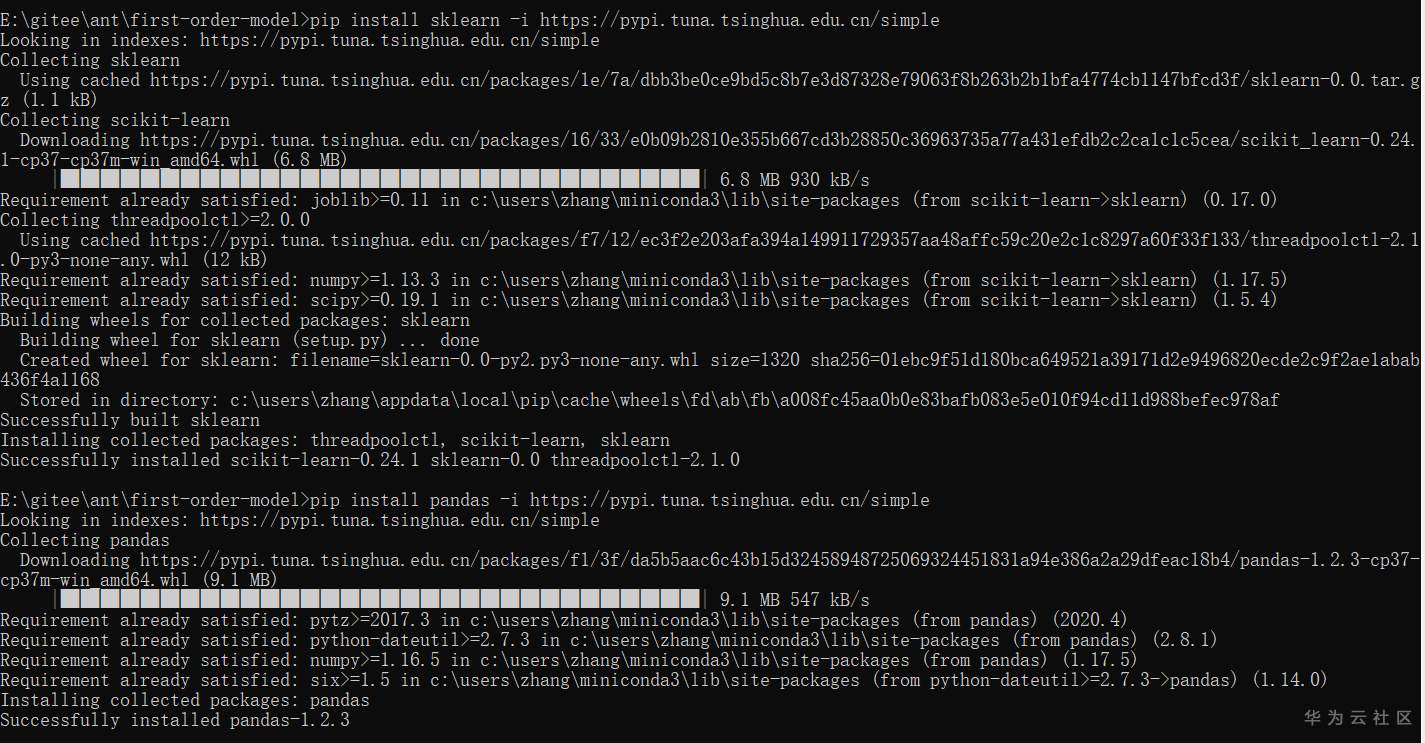

pip install sklearn -i https://pypi.tuna.tsinghua.edu.cn/simple

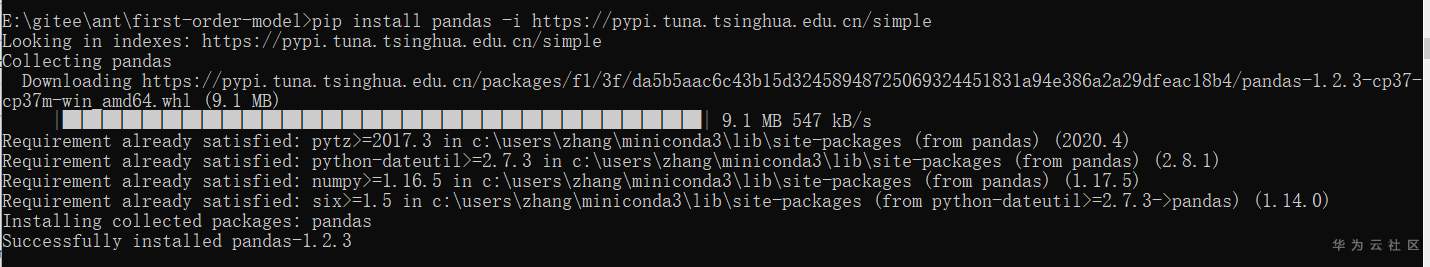

pip install pandas -i https://pypi.tuna.tsinghua.edu.cn/simple

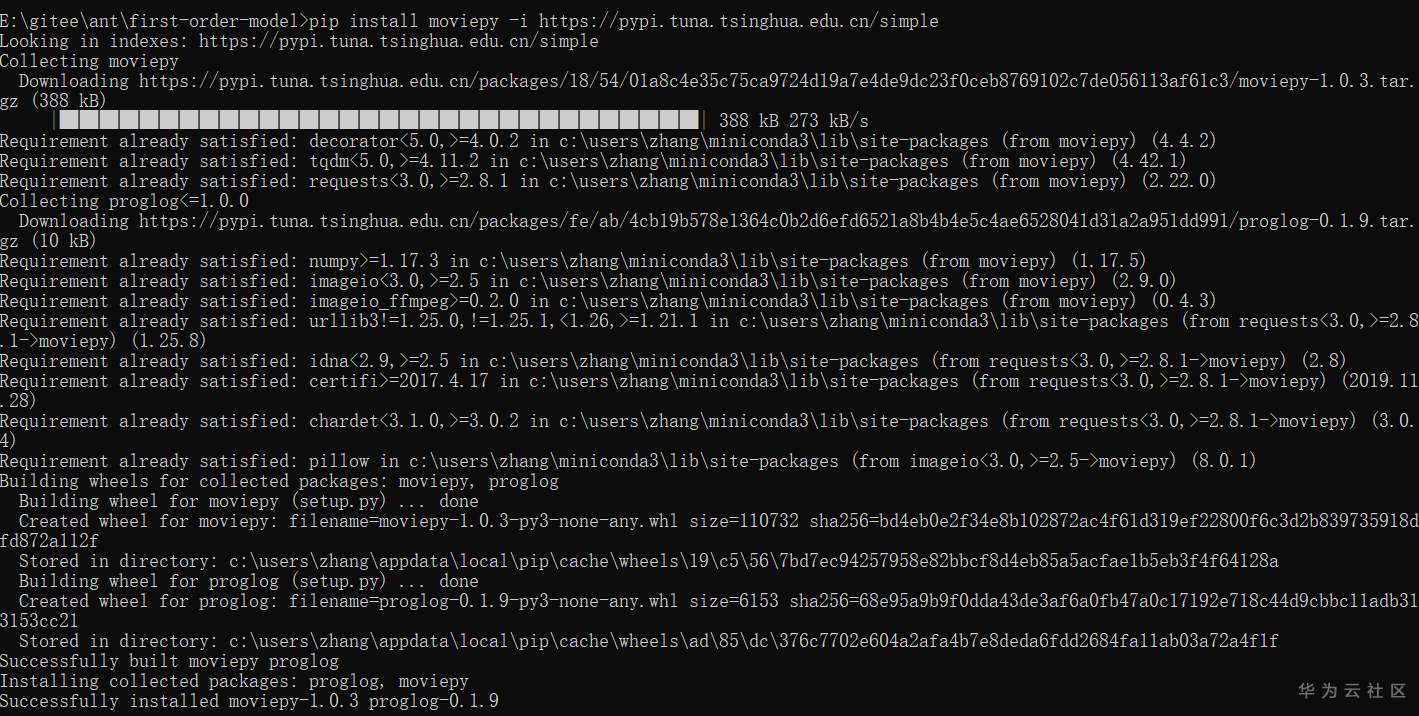

pip install moviepy -i https://pypi.tuna.tsinghua.edu.cn/simple

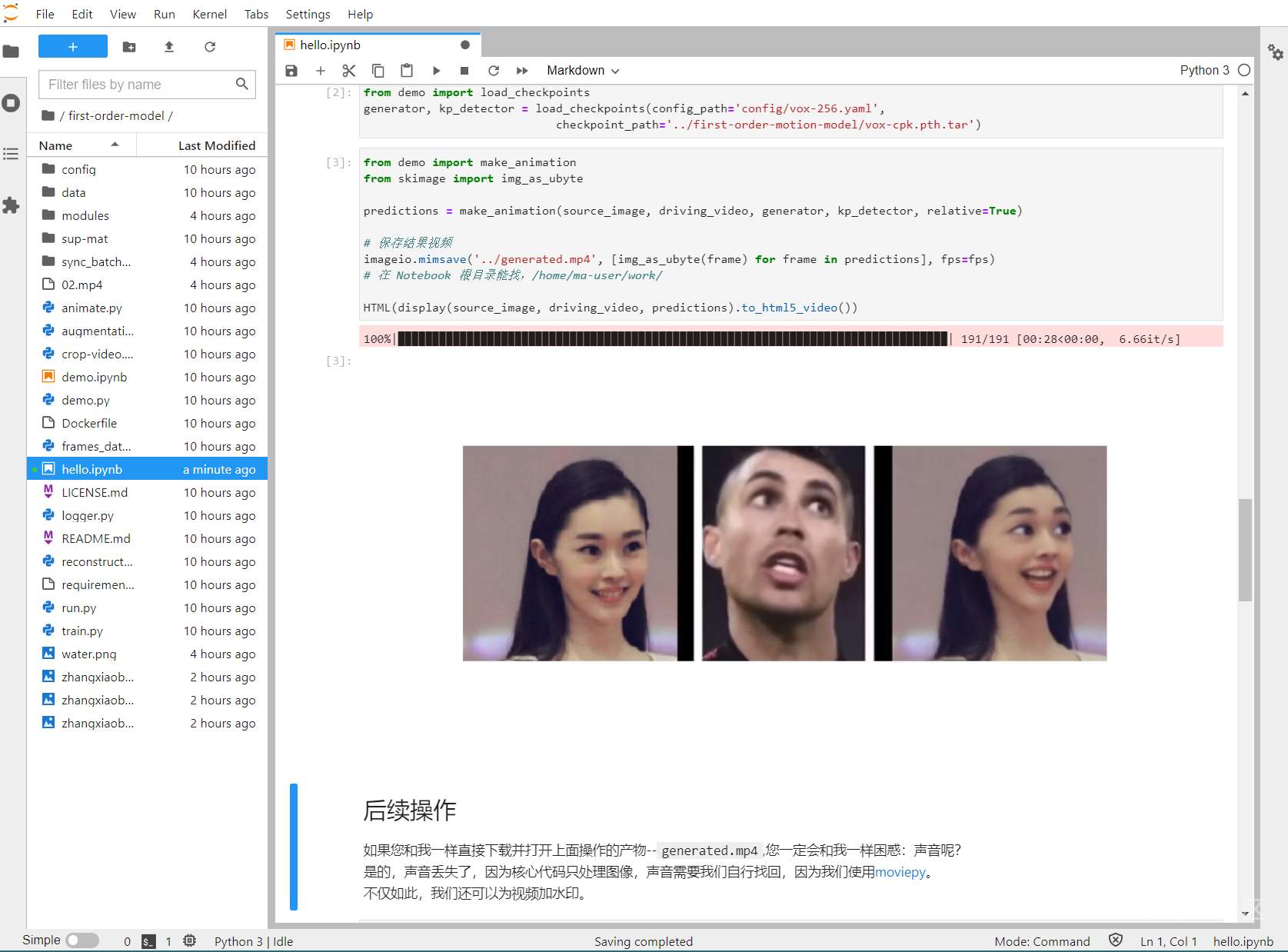

重新运行第一个cell

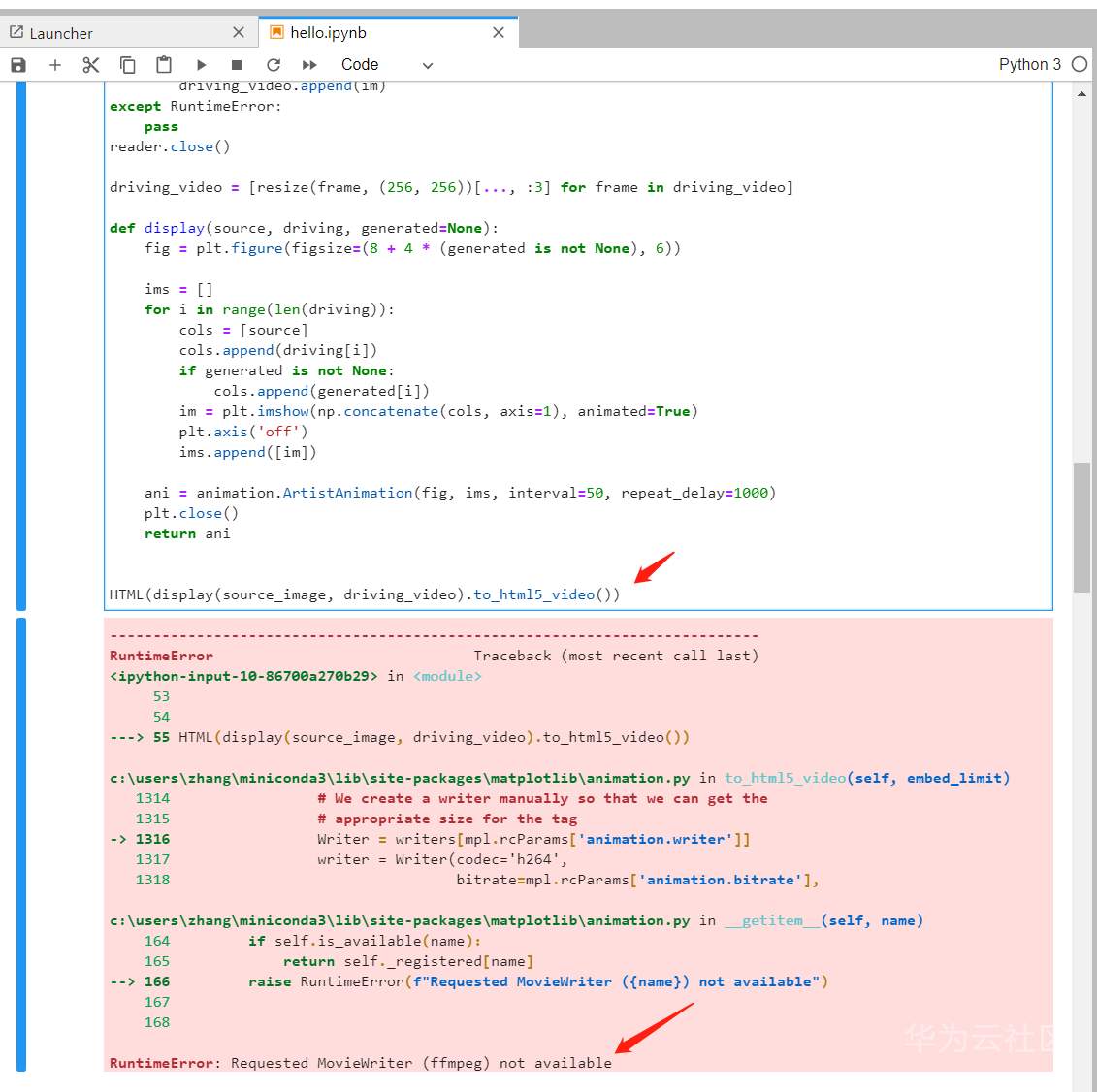

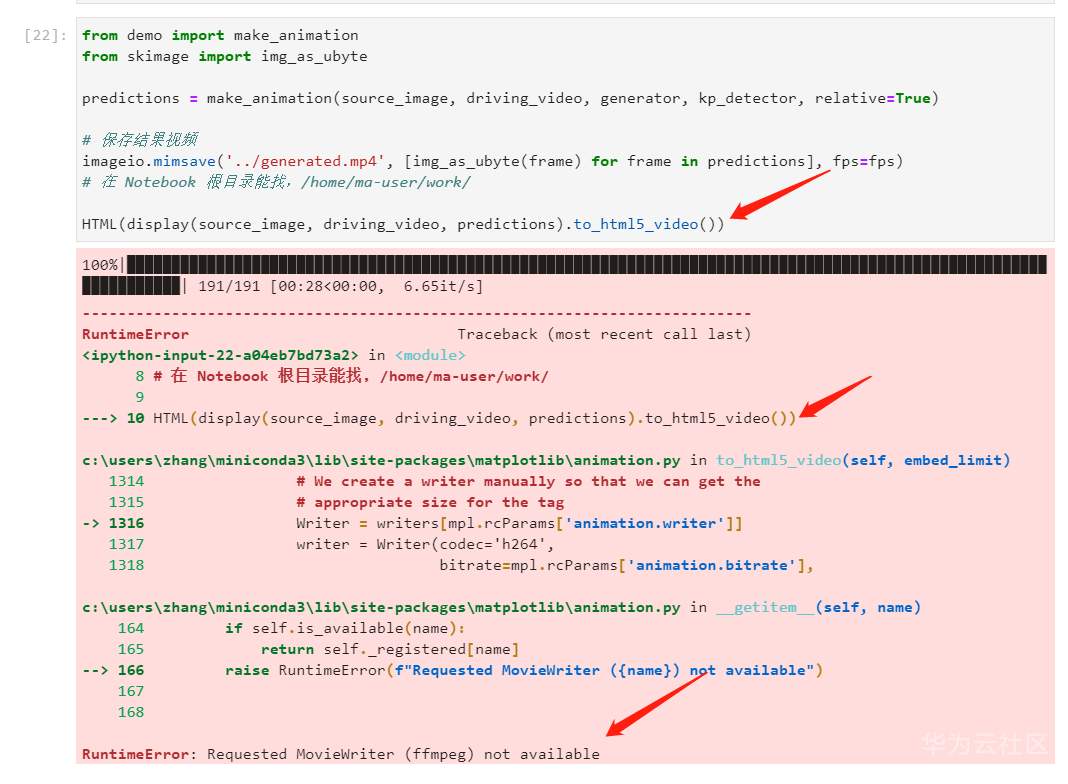

是最后一个Python语句 HTML(display(source_image, driving_video).to_html5_video()) 报错了

那看来前面转换什么的应该都OK了。只是没法展示结果。这个问题稍后解决,张小白决定先跑完其他脚本,待会儿回头再看看。

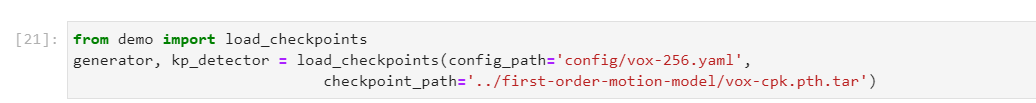

跑下面的cell

成功。

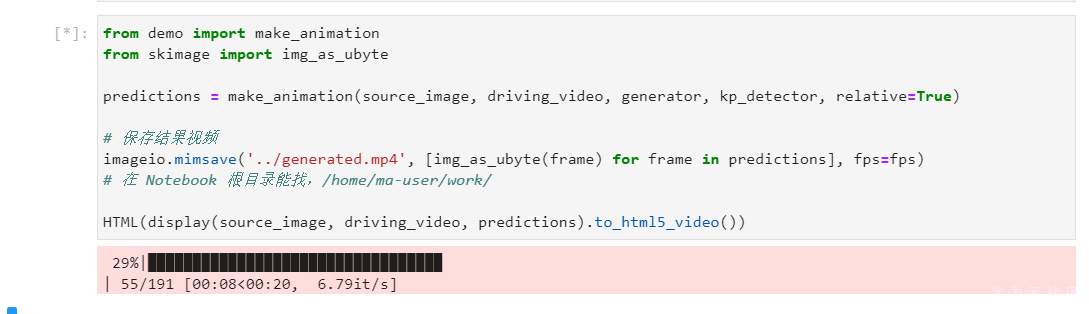

跑下面的cell

文件可以生成,,,,但是仍然是 HTML(display(source_image, driving_video, predictions).to_html5_video()) 报错。暂时忽略。。

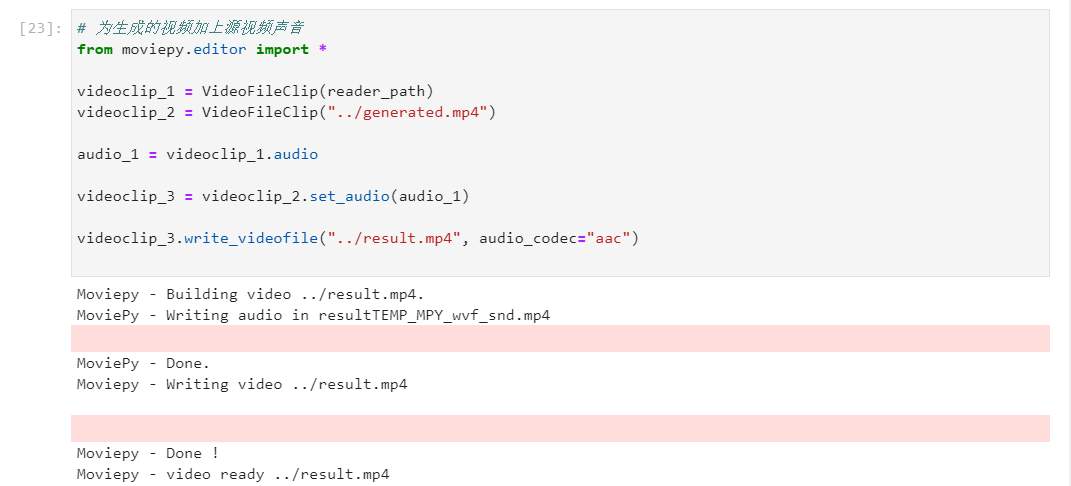

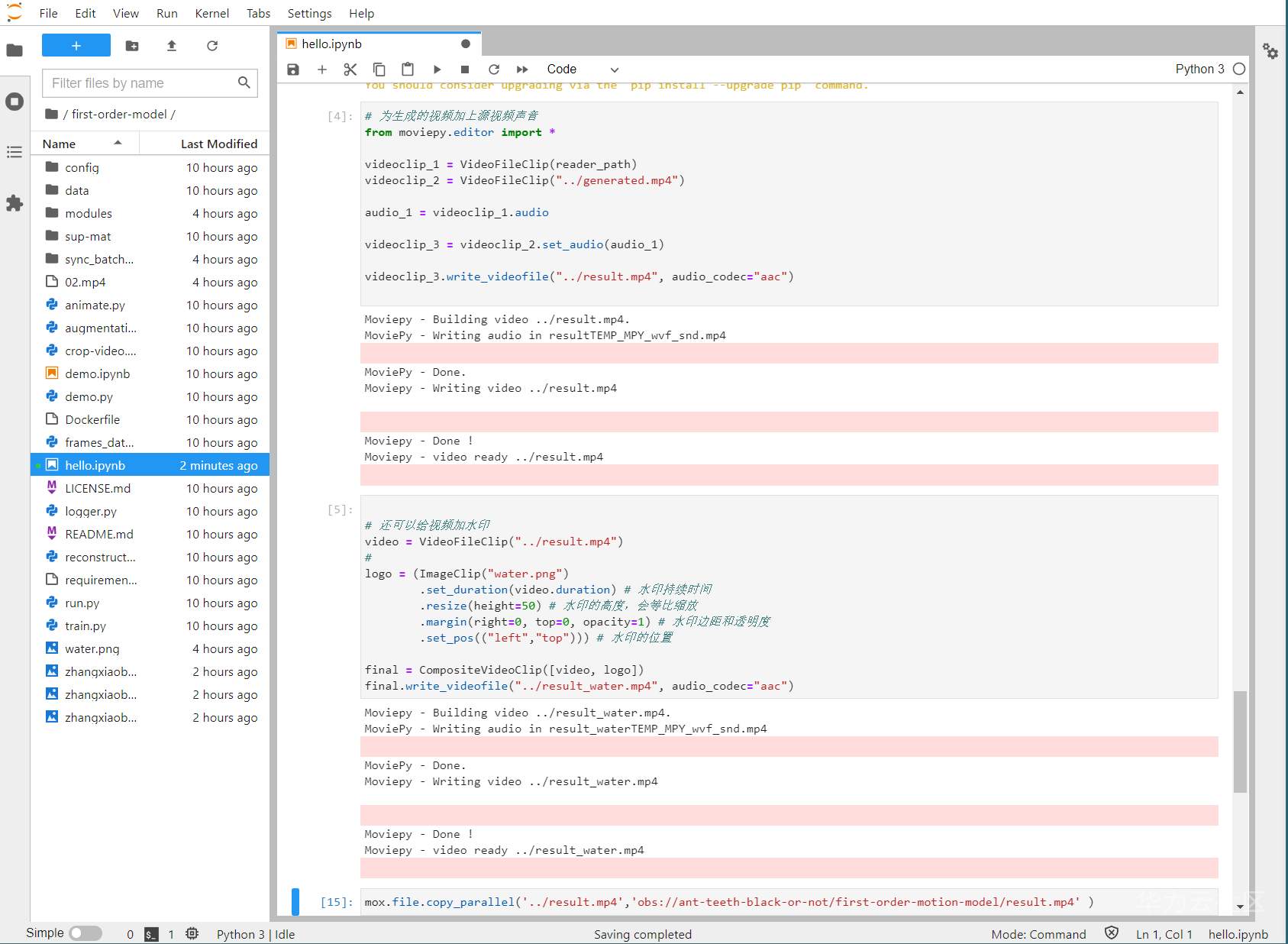

执行加声音cell:

也成功了。

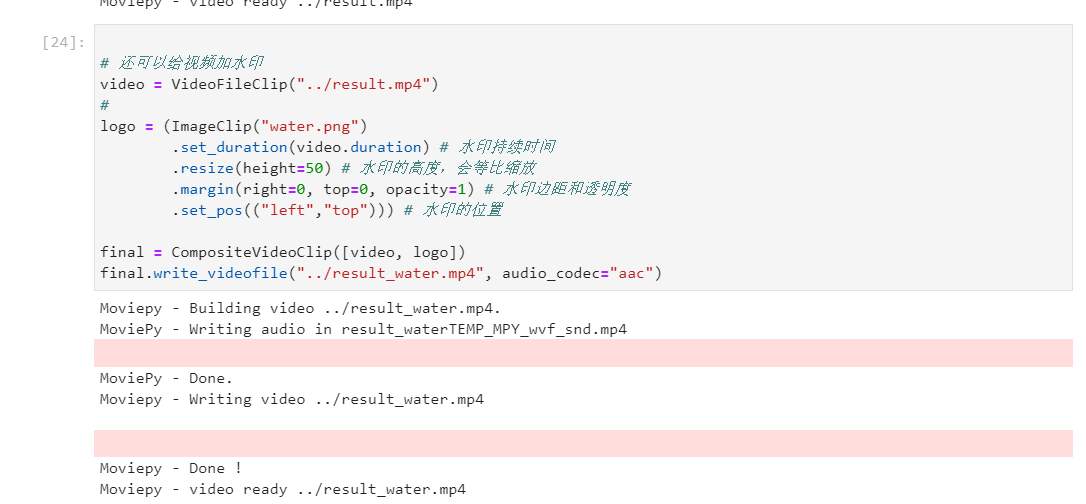

最后执行加水印的cell

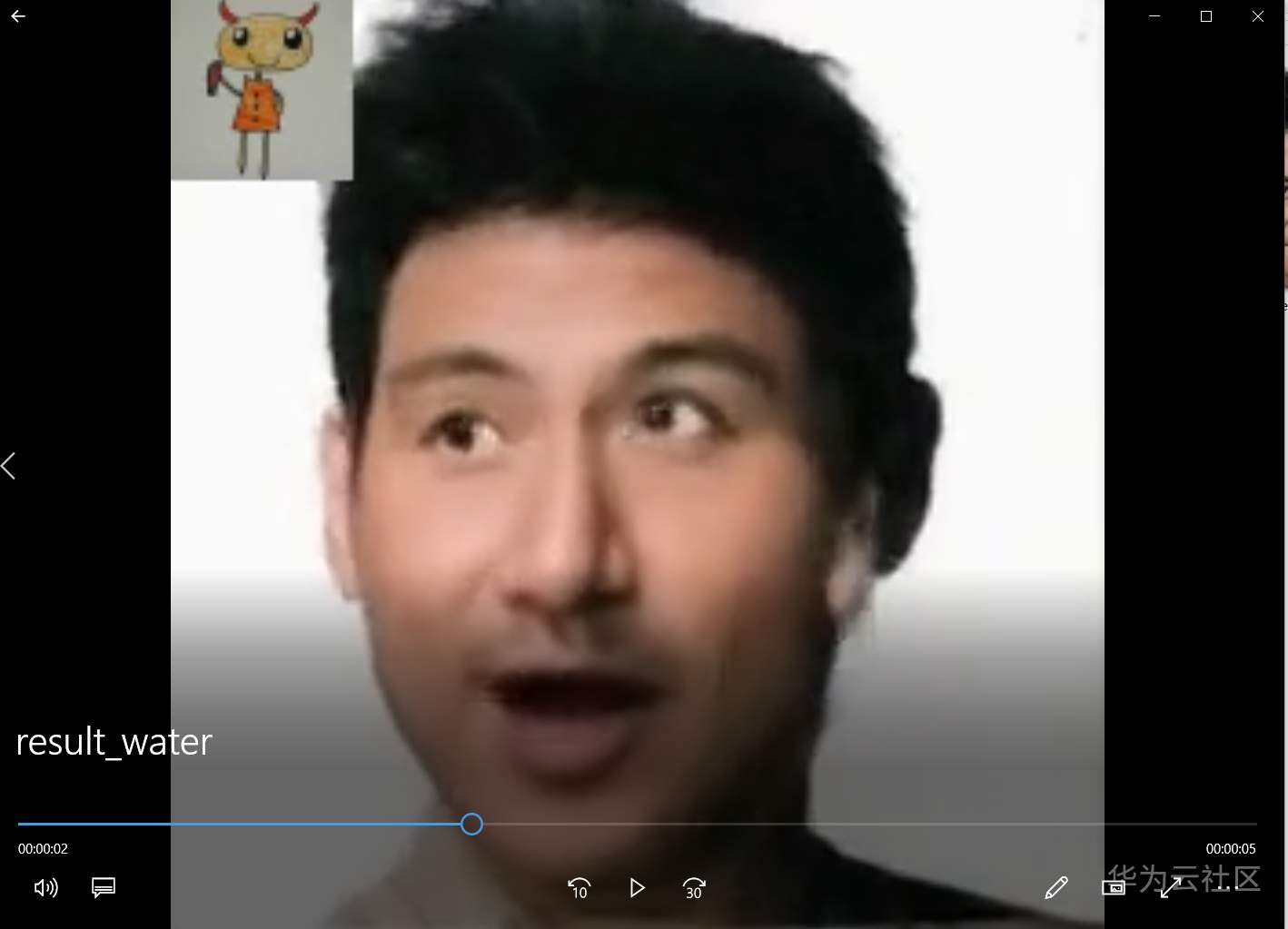

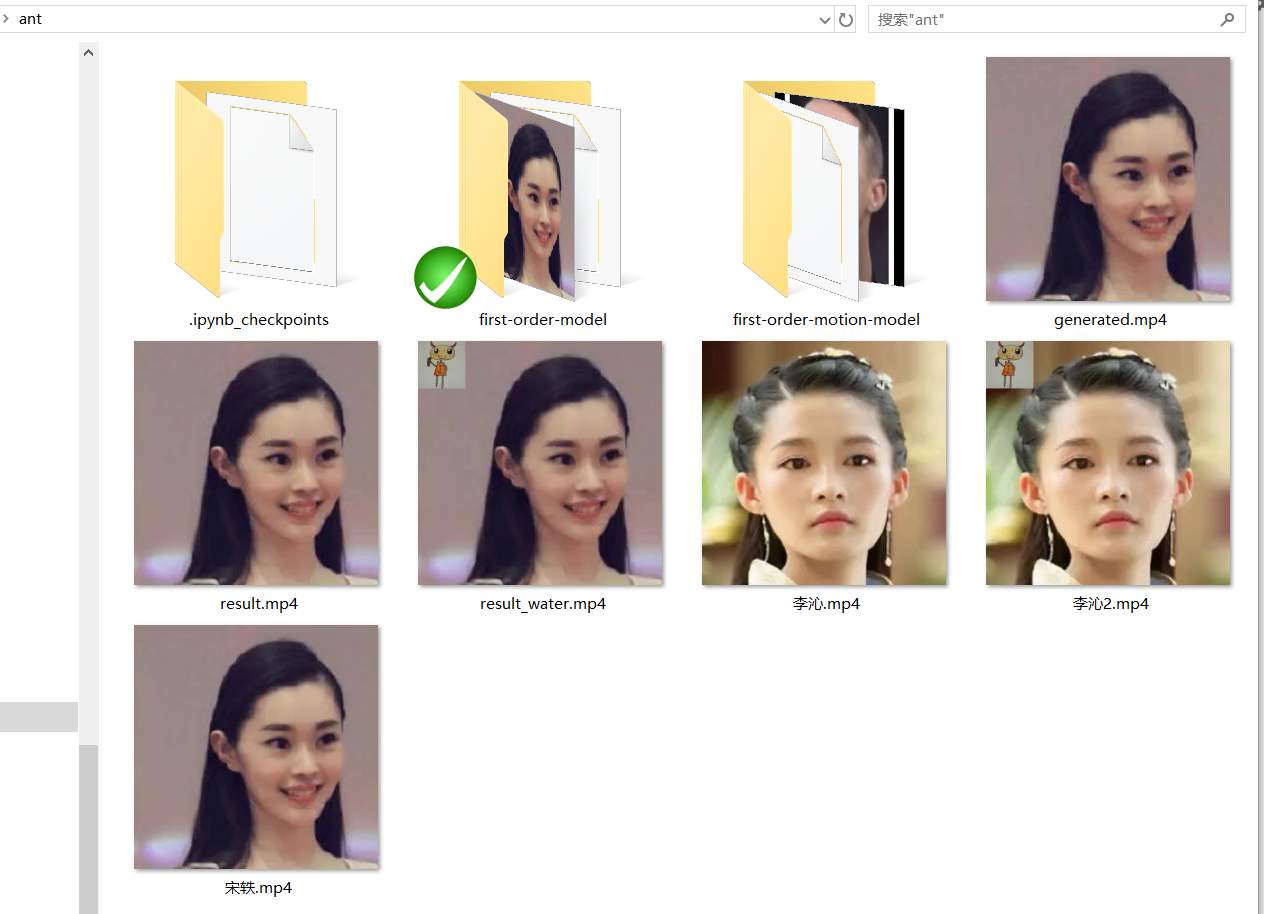

到资源管理器上看一看,三个视频文件其实都生成了。

打开好像也没有任何问题:

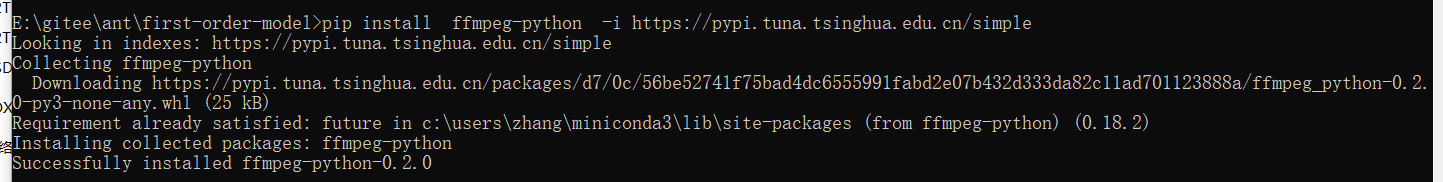

最后解决下报错的问题。

经过张小白紧张的搜索,看来再需要装一些ffmpeg的软件:

pip install ffmpeg-python -i https://pypi.tuna.tsinghua.edu.cn/simple

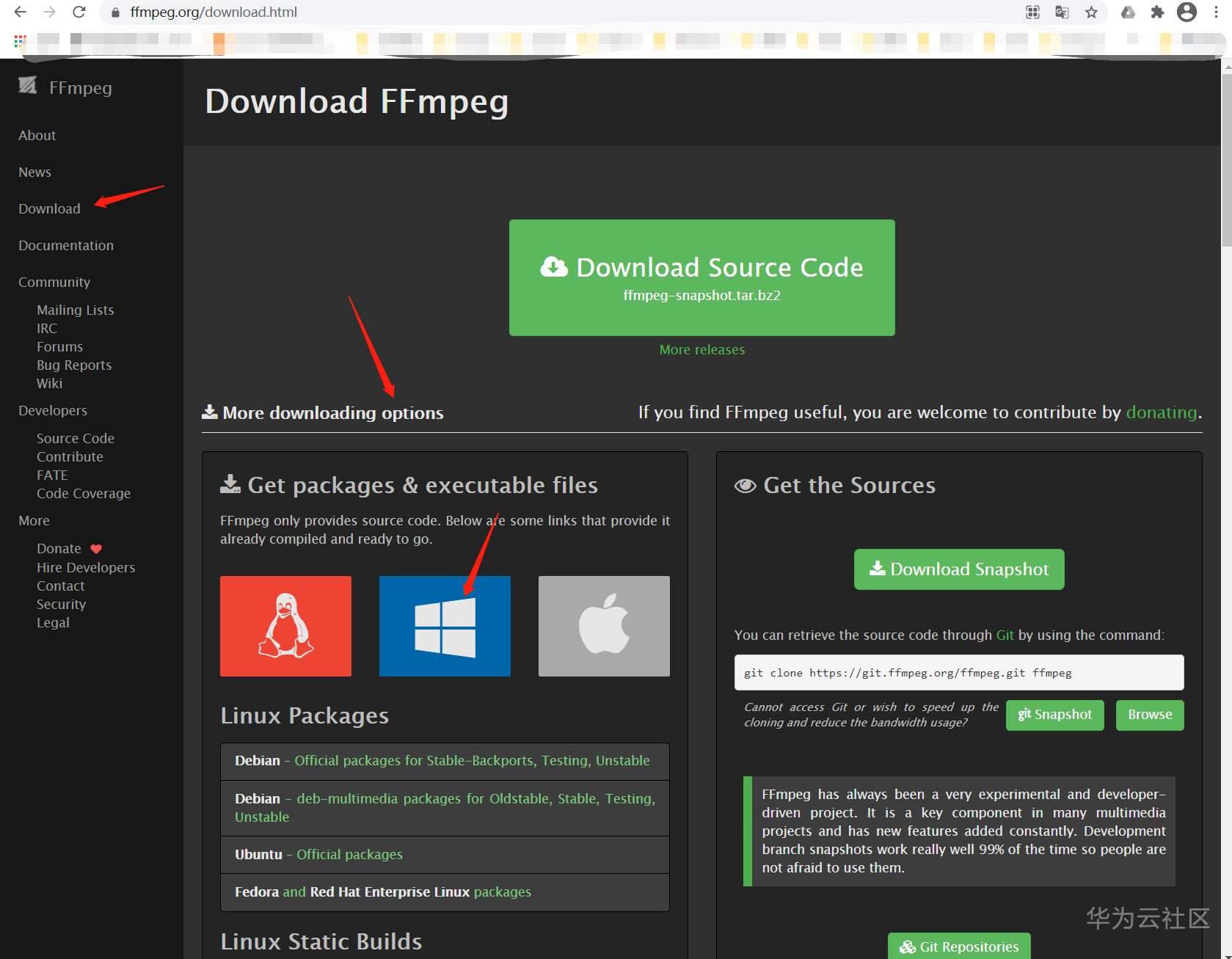

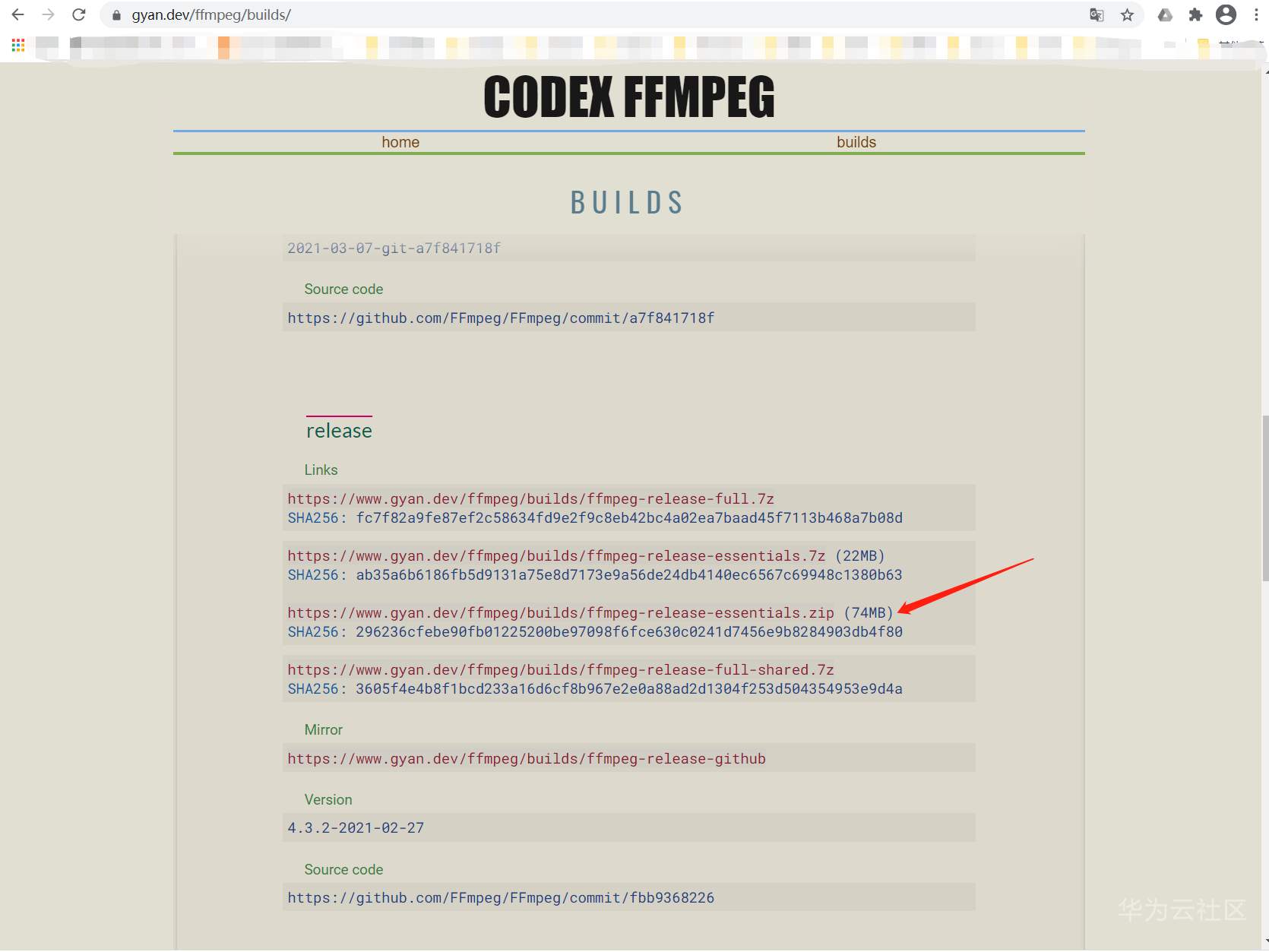

需要到 https://ffmpeg.org/download.html 去下载ffmpeg的windows的包

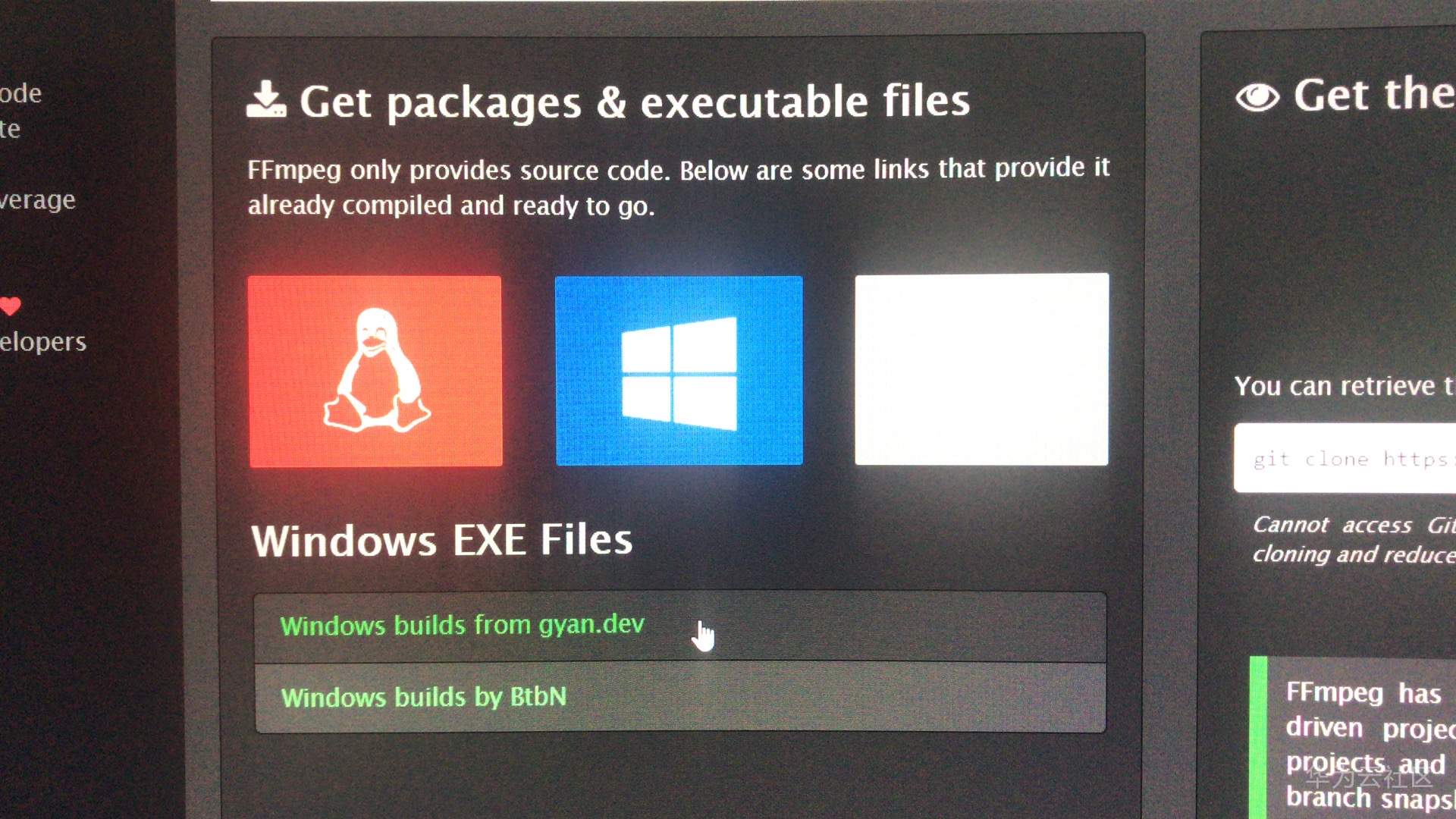

鼠标需要悬停在windows图标上面,然后出现以下画面:

点击第一个windows builds from gyan.dev

会进入新的页面 https://www.gyan.dev/ffmpeg/builds/

找到release的地方,点击链接下载zip包:

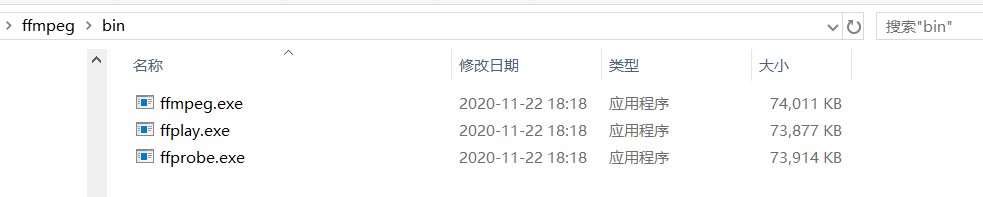

下载完毕后,将其解压到 C:\ffmpeg目录下

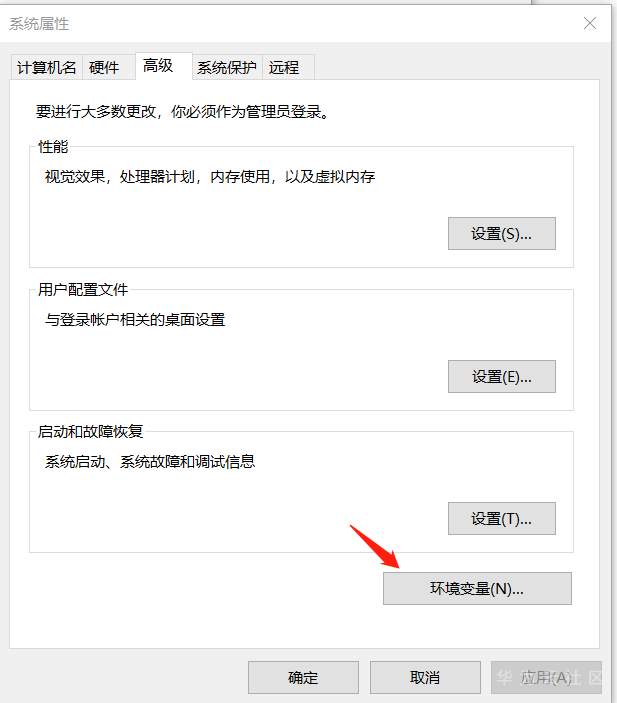

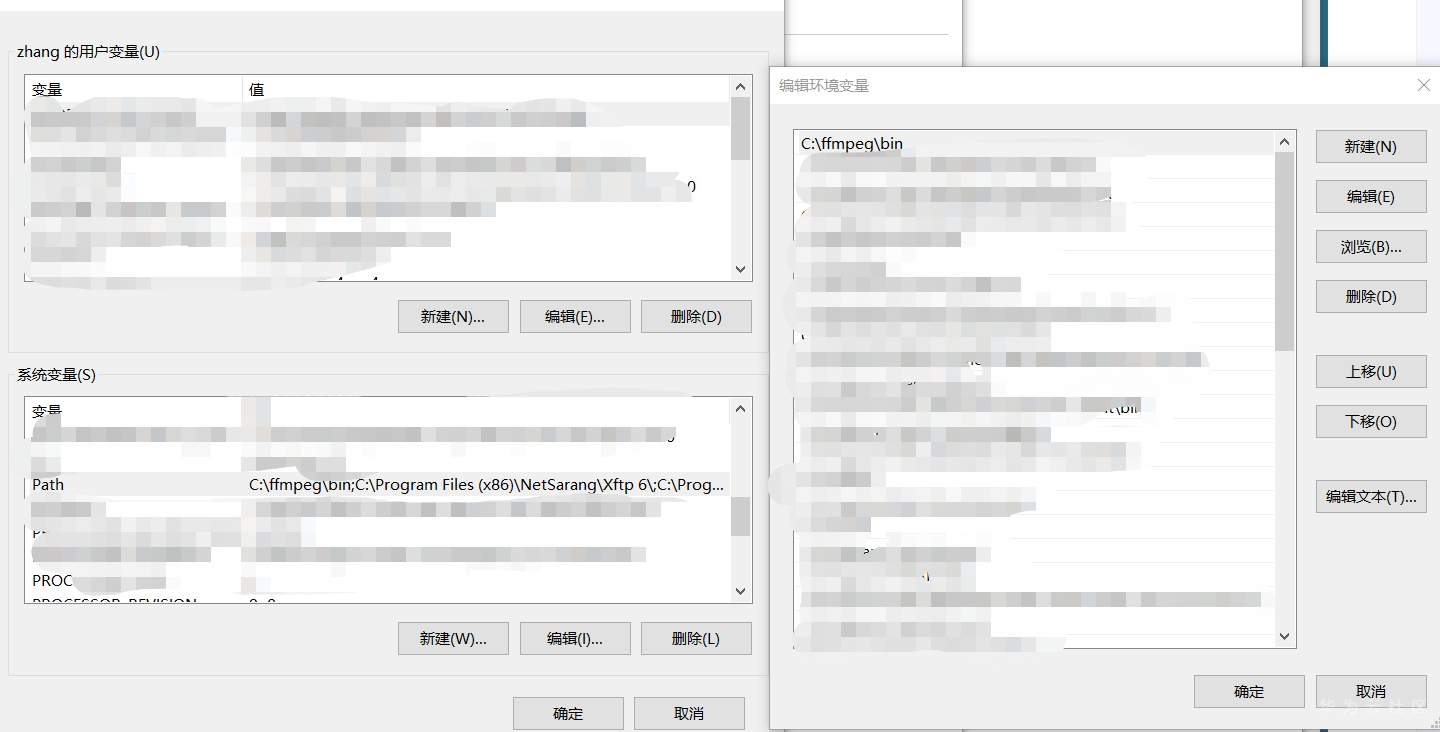

到系统变量的设置中,设置C:\ffmpeg\bin的目录:

确定后需要重启windows系统(当然也可以放到用户变量中,就不用重启。)

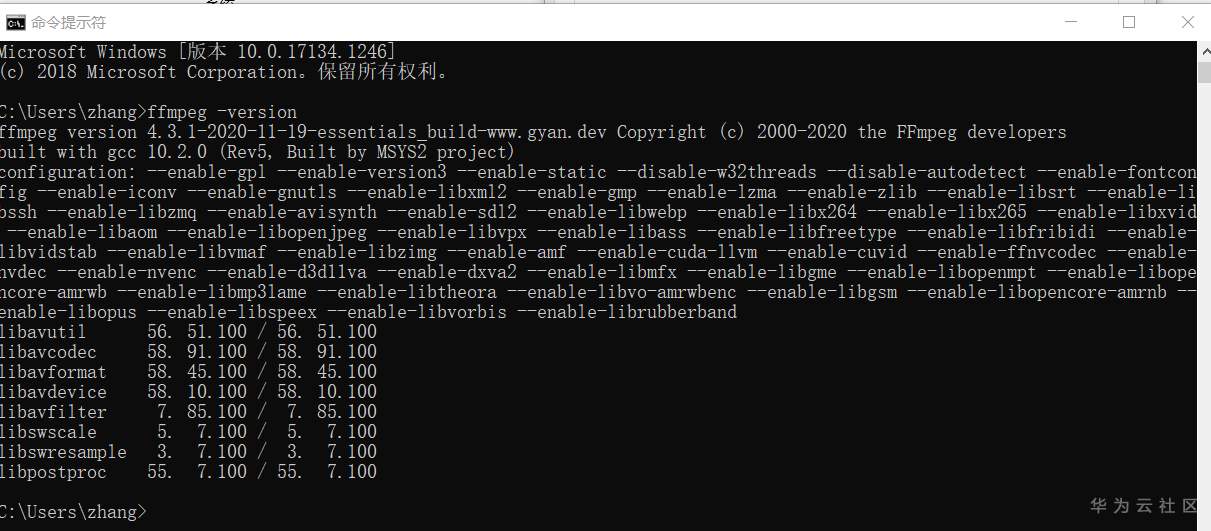

重启后,在命令行下任意目录,输入 ffmpeg -version

此时ffmpeg已就绪。

再重新打开jupyterLab

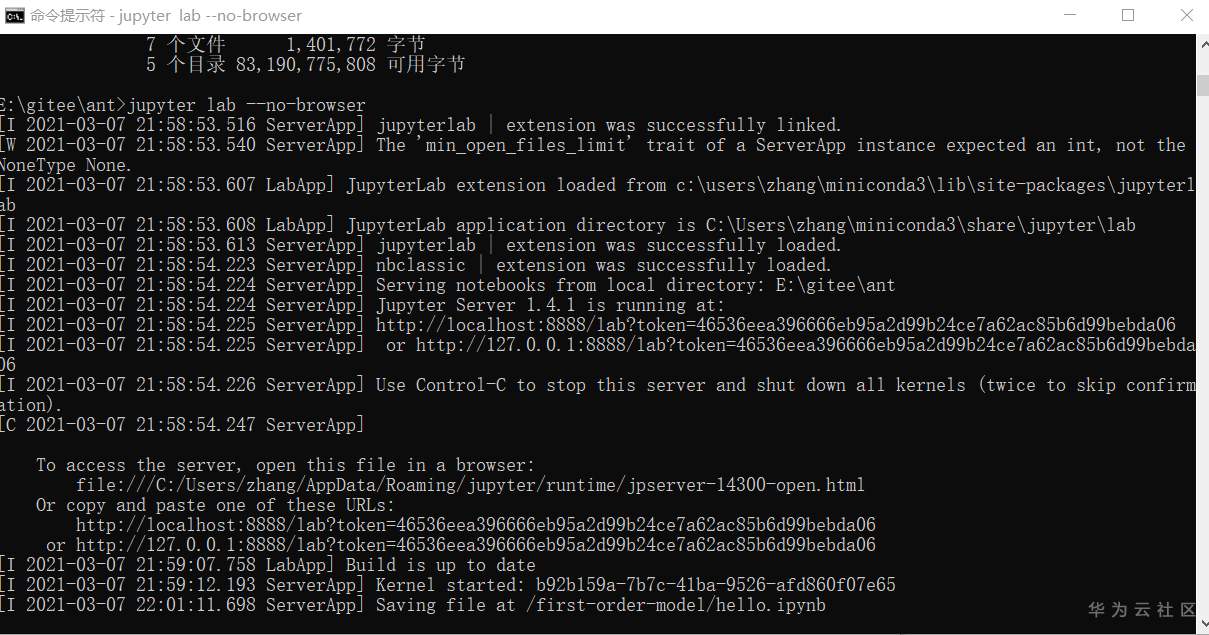

命令行下启动 jupyter lab --no-browser

打开后台服务标识的地址:http://localhost:8888/lab?token=46536eea396666eb95a2d99b24ce7a62ac85b6d99bebda06

惯例打开 hello.ipynb

执行前面出错的那个cell

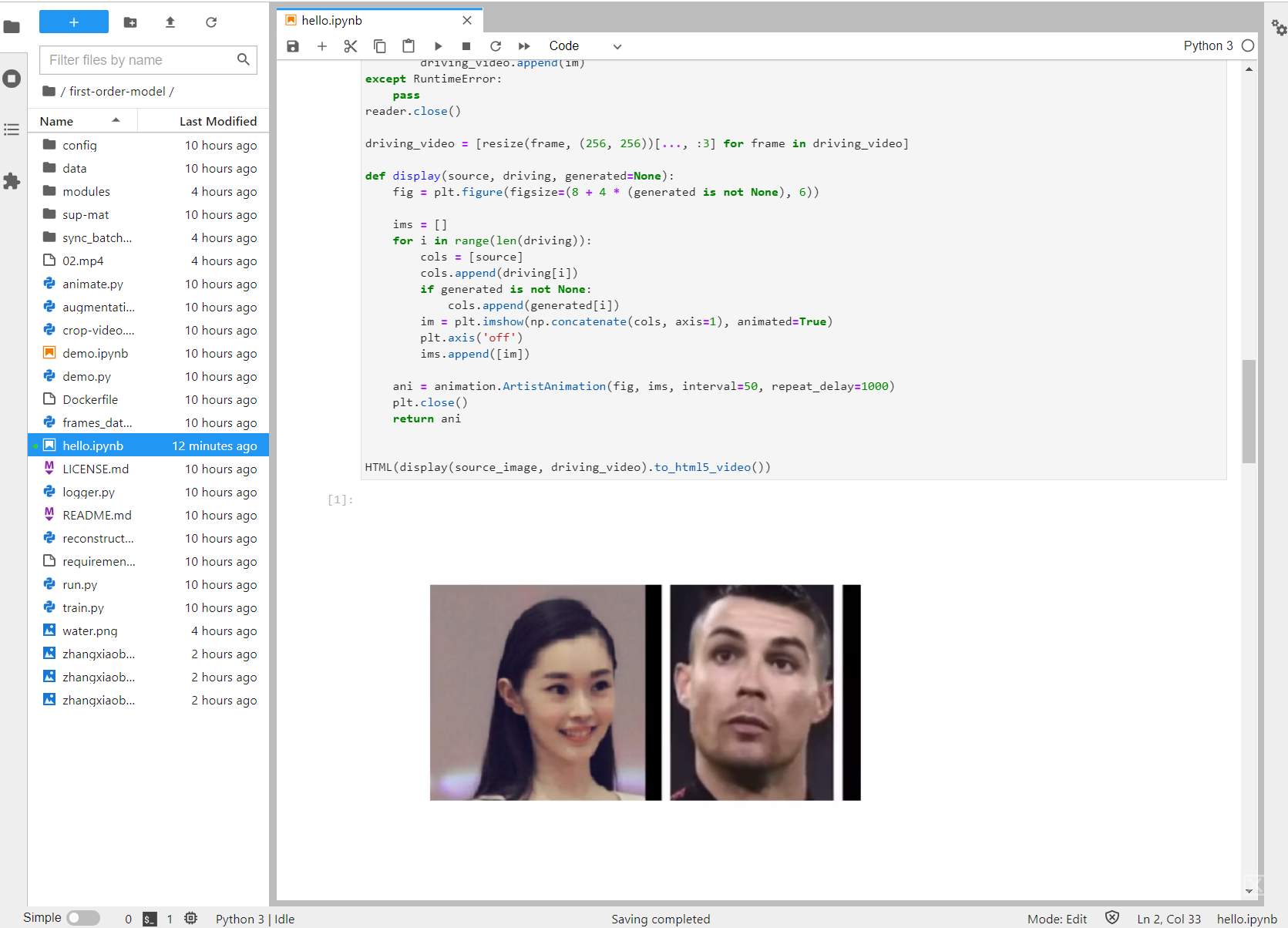

哈哈,终于不报错了。

再依次执行

这回全部正常了。。。

完美收官。

这就是你们要的蚂蚁牙黑,美女牙白。。。

(全文完,谢谢阅读)

- 点赞

- 收藏

- 关注作者

评论(0)