从零开始实施推荐系统的落地部署——10.大数据平台的搭建遇到问题和解决方法(二)

【摘要】 配置好spark,启动spark-sql出现下面情况:把所有程序都关闭,重新启动,发现stan1,stan2的启动没提示报错,关闭却是没进程,经查看,原来是之前的关闭程序有50010,50020,50075,8485还被暂用导致。(在以前虚拟机采用的是最小linux系统安装,不会出现这种情况)。还有出现zkfc也没有进程。需要重新格式化namenode,并且先删除current。经过以上步骤...

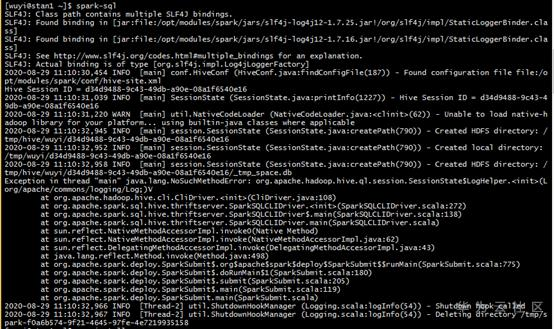

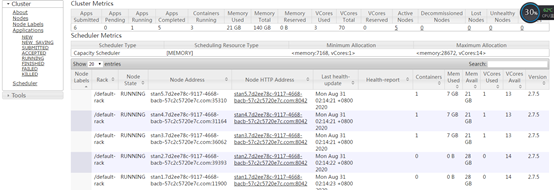

配置好spark,启动spark-sql出现下面情况:

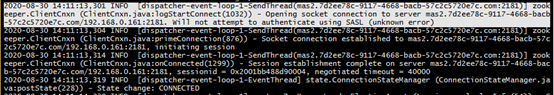

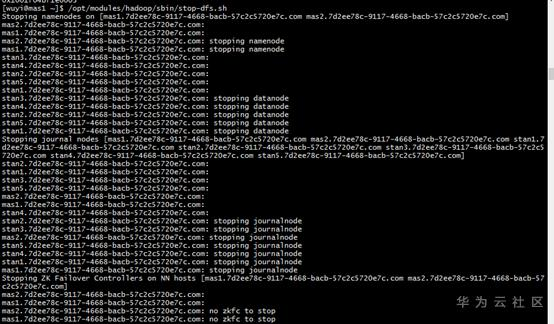

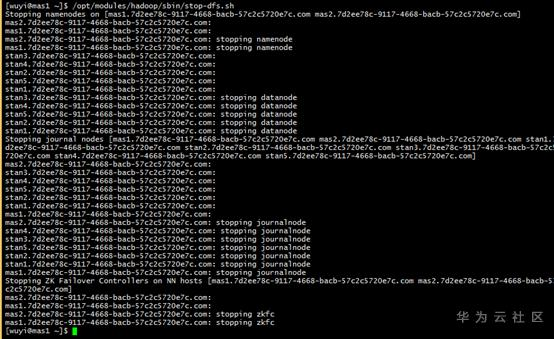

把所有程序都关闭,重新启动,发现stan1,stan2的启动没提示报错,关闭却是没进程,经查看,原来是之前的关闭程序有50010,50020,50075,8485还被暂用导致。(在以前虚拟机采用的是最小linux系统安装,不会出现这种情况)。还有出现zkfc也没有进程。需要重新格式化namenode,并且先删除current。

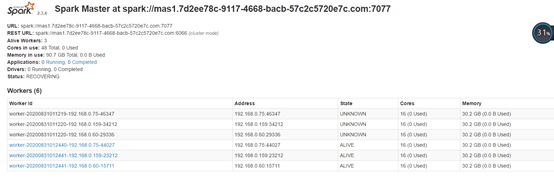

经过以上步骤:hadoop的hdfs能正常运行。但是spark2.2.2按照以前的步骤还是出错。更换spark2.3.4版本后,正常运行。之前的版本应该是jar包冲突问题。这个问题后面有时间再排查原因。

大数据平台基本框架终于搭建完成,可以进一步学习推荐系统

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)