《Spark数据分析:基于Python语言 》 —2.3 获取Spark

2.3 获取Spark

要把Spark安装到特定系统上,最简单的方式是使用正式版的Spark下载包。正式版Spark的包可以在http://spark.apache.org/downloads.html下载到。这些下载包是跨平台的。Spark运行在JVM环境中,而JVM是平台无关的。

你也可以选择使用Spark官方网站上提供的编译指令,下载Spark源码并自行编译,不过这种方式稍显复杂。

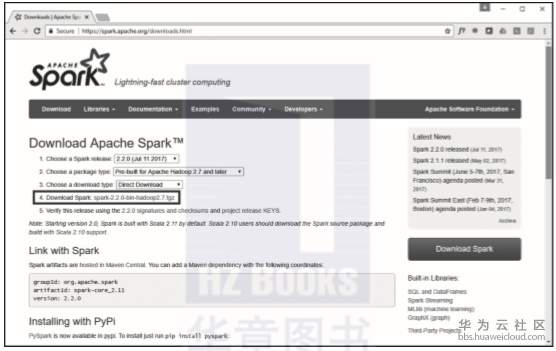

如果你要下载Spark的正式版,你应该选择带Hadoop支持的编译版本,如图2.2所示。为了避免望文生义,需要澄清的是带有Hadoop支持的Spark并没有包含Hadoop本身。这些包里面只是包含了用于集成Hadoop集群与所列Hadoop发行版的库。不论是否在Hadoop上使用Spark, Hadoop里的许多类在运行时都是需要的。

图2.2 下载正式版的Spark

使用不带Hadoop支持的编译版本

如果你想以独立集群模式部署Spark,并且不用Hadoop的话,可能会受下载页面误导下载不带Hadoop支持的版本,或者用户自行提供Hadoop的版本,也就是文件名类似“spark- x.x.x-bin-without-hadoop.tgz”的包。这种命名容易误导人,这种包其实需要很多在Hadoop中实现的类已经在系统中存在。总的来说,一般情况下最好还是下载spark-x.x.x-bin-hadoopx.x这样的带Hadoop编译的包。

Spark一般也会在Hadoop的大多数商业发行版中提供,包括如下所列这些:

Cloudera的Hadoop发行版(CDH)。

Hortonworks数据平台(Hortonworks Data Platform,HDP)。

MapR融合数据平台(MapR Converged Data Platform)。

另外,在主流的云服务厂商提供的托管Hadoop架构中都包含Spark,比如AWS的EMR服务、谷歌的Cloud Dataproc服务,以及微软的Azure HDInsight。

如果你已有现成的Hadoop环境,那么可能已经有了入门所需的一切,可以跳过后面几节关于安装Spark的部分。

- 点赞

- 收藏

- 关注作者

评论(0)