《Spark数据分析:基于Python语言 》 —2.1.2 Spark独立集群

【摘要】 本节书摘来自华章计算机《Spark数据分析:基于Python语言 》 一书中第2章,第2.1.2节,作者是[澳] 杰夫瑞·艾文(Jeffrey Aven) ,王道远 译。

2.1.2 Spark独立集群

Spark独立集群指Spark内建的,或者说“独立”的调度器。我们会在第3章中进一步了解调度器,也就是集群管理器的功能。

独立(standalone)这个术语有点误导人,“独立”容易被理解为集群的拓扑关系,其实这个“独立”和拓扑关系无关。比如,你完全可以在一个真正的多节点分布式集群上以独立集群模式部署Spark,在这里“独立”的意思是无需任何外部调度器。

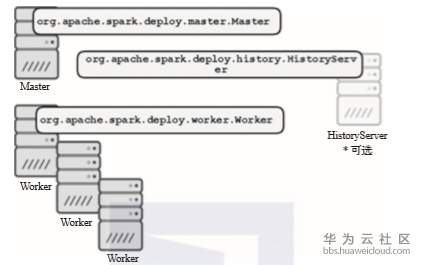

一个Spark独立集群内有多个主机进程或者服务在运行,各个服务分别为集群上运行的Spark应用提供计划、协调、管理等方面的功能。图2.1展示了一个完整的分布式Spark独立集群的拓扑结构(第3章会详细介绍这些服务提供的功能)。

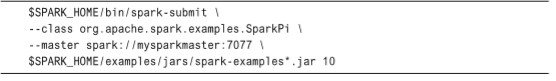

在提交Spark应用时,只要在提交的URI中指定spark作为协议名,并且设置好Spark主进程运行的主机地址和所监听的端口号,就可以把应用提交到Spark独立集群上。程序清单2.2展示了一个这样的例子。

程序清单2.2 向Spark独立集群提交Spark作业

使用Spark独立集群,你可以快速上手并且把程序跑起来,因为几乎没有依赖,无需考虑环境。Spark独立集群中包含各种具体的角色需要主机去充当,而每个正式版的Spark里都包含上手所需的全部内容,包括这些主机所需要的二进制文件和配置文件。在本章后续部分中,你会部署你的第一个Spark独立模式的集群。

图2.1 Spark独立集群

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)