MRS集群配置Kettle on Spark

本文将介绍如何通过在Linux的机器上,执行kettle脚本,在MRS集群中,运行Spark程序。

按照本文操作,你需要:

一个MRS集群

(可选)集群外的一个Linux节点(与MRS集群在相同VPC,相同安全组规则下)

1. 下载Kettle,在windows上图形界面上编辑得到一个xml模板

首先,可以从这个链接下载Kettle。

https://nchc.dl.sourceforge.net/project/pentaho/Data%20Integration/7.1/pdi-ce-7.1.0.0-12.zip

下载后,解压,运行

pdi-ce-7.1.0.0-12\data-integration\Spoon.bat

这样会打开kettle的图形化界面。

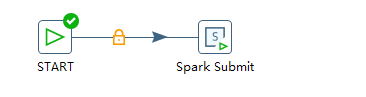

点击文件-新建-作业,创建一个新的作业。

从左边的核心对象-通用中,拖入一个START节点。

再拖入一个Spark Submit节点。

将鼠标悬停在START按钮上几秒后,会弹出一个选项菜单,点击下图按钮,将START和Spark Submit连接起来

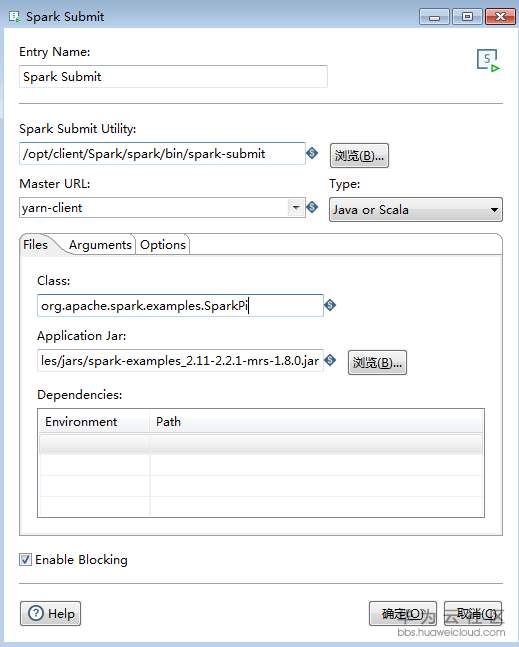

双击Spark Submit,编辑Spark作业信息。

填入的内容分别是:

Spark Submit Utility: /opt/client/Spark/spark/bin/spark-submit

Master URL: yarn-client

Class: org.apache.spark.examples.SparkPi

Application Jar: /opt/client/Spark/spark/examples/jars/spark-examples_2.11-2.2.1-mrs-1.8.0.jar (请根据集群版本调整)

Arguments: 100

这样,就完成了整个作业的配置,文件-保存,保存为test,会生成一个test.kjb文件。

2. 在Linux上部署、运行

2.1 下载MRS客户端

如果在MRS master节点上部署Kettle,则不需要重新安装客户端,MRS master节点默认在/opt/client目录下安装好了客户端。

如果在集群外Linux节点上部署Kettle,需要先在该节点上安装MRS客户端,具体请参考https://support.huaweicloud.cn/eu-west-0-usermanual-mrs/mrs_01_0091.html

假设我们最后也将客户端安装在了/opt/client目录下。

2.2 部署、配置Kettle

将下载的pdi-ce-7.1.0.0-12.zip包也传到linux节点,假设传到了/root/用户目录下。

执行命令解压

unzip pdi-ce-7.1.0.0-12.zip

执行命令,将集群的配置拷贝到Kettle的对应目录

yes | cp /opt/client/Spark/spark/conf/*-site.xml /root/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations/hdp25/

将前面保存好的test.kjb传到linux节点,传到/root/test.kjb.

source MRS的环境变量, 里面会设置JAVA_HOME和SPARK_HOME

source /opt/client/bigdata_env

设置HADOOP_CONF_DIR

export HADOOP_CONF_DIR=/root/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations/hdp25

执行命令,即可运行Spark程序

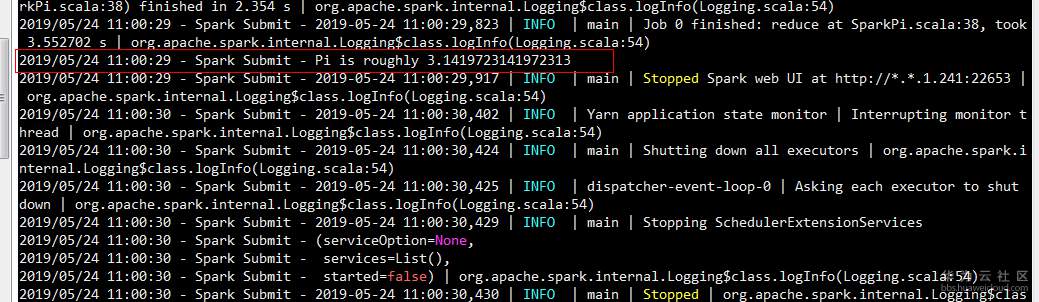

/root/data-integration/kitchen.sh -file /root/test.kjb

可以看到执行成功,打印出了π的计算结果。

之前填入的参数,都可以在生成的test.kjb文件中手动修改。

参考

- 点赞

- 收藏

- 关注作者

评论(0)